Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Når AI-agenter nærmer seg bruk i den virkelige verden, hvordan vet vi hva de faktisk kan gjøre? Pålitelige benchmarks er kritiske, men agentiske benchmarks er brutt!

Eksempel: WebArena markerer "45+8 minutter" på en varighetsberegningsoppgave som riktig (reelt svar: "63 minutter"). Andre referanseindekser feilestimerer agentkompetanse med 1,6-100 %.

Hvorfor er evalueringsgrunnlaget for agentiske systemer skjøre? Se nedenfor for tråd og lenker

1/8

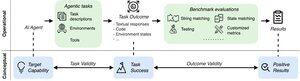

Agentiske evalueringer skiller seg fra tradisjonelle ML-benchmarks når det gjelder oppgaveformulering og resultat.

Agentiske benchmarks er ofte avhengige av skjøre simulatorer (leketøysnettsteder, databaser) potensielt med feil og snarveier som kan forvrenge resultatene. Videre har oppgaveresultater av agentiske benchmarks ingen faste "gull"-etiketter og må ofte bedømme ustrukturerte svar (kode, API-kall, lange tekster.)

3/8

For å møte disse utfordringene bør agentiske benchmarks ta sikte på å sikre sammenhengen mellom et positivt evalueringsresultat og AI-agentenes evne. Vi deler opp dette målet i to essensielle validitetskriterier:

1. Oppgavegyldighet: En oppgave kan løses hvis og bare hvis agenten har målevnen.

2. Resultatgyldighet: Evalueringsresultatet er positivt hvis og bare hvis oppgaven er løst.

4/8

Forankret i 17 populære benchmarks (f.eks. SWE-bench, OSWorld, TAU-bench, etc.), utvikler vi en 43-elements agentic benchmark checklist (ABC) for raskt å identifisere i hvilken grad en agentisk benchmark tilfredsstiller oppgave- og resultatvaliditet

ABC:

5/8

Vi brukte ABC på 10 virkningsfulle benchmarks som ble brukt til å evaluere o3, Gemini 2.5 og Sonnet 4. Her er en oversikt over funnene våre:

1. 7/10 benchmarks mislykkes utfallsvaliditet

2. 7/10 inneholder skjulte snarveier/uløselige oppgaver

3. Bare 2/10 avslører kjente problemer

Følg med. Vi vil snart gi ut flere kvantitative detaljer og rettelser for problemene som er identifisert!

6/8

ABC gir både benchmark- og modellutviklere mulighet til å oppdage og fikse feil – før overskriftsresultater.

Utforsk hele sjekklisten, eksemplene, og bidra via nettstedet vårt og GitHub-repo for å bygge benchmarks som er verdig grense-AI sammen.

7/8

Dette er et felles arbeid med @maxYuxuanZhu, @yadapruksachatk og andre folk fra Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon og UK AISI.

8/8

21,97K

Topp

Rangering

Favoritter