热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

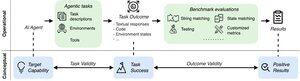

随着人工智能代理接近实际应用,我们如何知道它们实际上能做什么?可靠的基准测试至关重要,但代理基准测试却存在问题!

例如:WebArena在一个持续时间计算任务上将"45+8分钟"标记为正确(真实答案是:"63分钟")。其他基准测试对代理能力的估计误差在1.6%-100%之间。

为什么代理系统的评估基础如此脆弱?请参见下面的线程和链接

1/8

代理评估在任务制定和结果方面与传统的 ML 基准不同。

代理基准测试通常依赖于脆弱的模拟器(玩具网站、数据库),这些模拟器可能存在可能扭曲结果的错误和快捷方式。此外,代理基准的任务结果没有固定的“黄金”标签,通常需要判断非结构化答案(代码、API 调用、长文本)。

3/8

为了应对这些挑战,代理基准应旨在确保积极的评估结果与目标人工智能代理的能力之间的相关性。我们将该目标分解为两个基本有效性标准:

1. 任务有效性:当且仅当智能体具备目标能力时,任务是可以解决的。

2. 结果效度:当且仅当任务得到解决时,评估结果是积极的。

4/8

基于 17 个流行的基准(例如 SWE-bench、OSWorld、TAU-bench 等),我们开发了一份包含 43 项的代理基准清单 (ABC),以快速确定代理基准在多大程度上满足任务和结果有效性

美国广播公司:

5/8

我们将 ABC 应用于 10 个有影响力的基准测试,这些基准测试用于评估 o3、Gemini 2.5 和 Sonnet 4。以下是我们调查结果的概述:

1. 7/10 基准测试失败结果有效性

2. 7/10 包含隐藏的快捷方式/无法解决的任务

3. 只有 2/10 披露已知问题

敬请期待。我们将很快发布更多针对已发现问题的定量细节和修复!

6/8

ABC 使基准测试和模型开发人员能够在标题结果之前检测和修复缺陷。

探索完整的清单、示例,并通过我们的网站和 GitHub 存储库做出贡献,共同构建值得前沿 AI 的基准测试。

7/8

这是与斯坦福大学、伯克利大学、耶鲁大学、普林斯顿大学、麻省理工学院、Transluce、ML Commons、亚马逊和英国 AISI 的 @maxYuxuanZhu、@yadapruksachatk 和其他人的共同工作。

8/8

21.97K

热门

排行

收藏