Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jak můžeme vědět, co jako agenti umělé inteligence téměř v reálném světě dokážou? Spolehlivé benchmarky jsou kritické, ale agentické benchmarky jsou nefunkční!

Příklad: WebArena označí "45+8 minut" v úloze výpočtu doby trvání jako správnou (skutečná odpověď: "63 minut"). Jiné benchmarky nesprávně odhadují kompetenci agenta o 1,6-100 %.

Proč jsou základy hodnocení agentických systémů křehké? Vlákno a odkazy naleznete níže

1/8

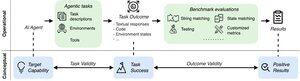

Agentická hodnocení se liší od tradičních benchmarků ML, pokud jde o formulaci úkolu a výsledek.

Agentické benchmarky se často spoléhají na křehké simulátory (webové stránky s hračkami, databáze) potenciálně s chybami a zkratkami, které mohou zkreslit výsledky. Kromě toho, výsledky úloh agentických benchmarků nemají žádné pevné "zlaté" štítky a často potřebují posuzovat nestrukturované odpovědi (kód, volání API, dlouhé texty).

3/8

Aby bylo možné tyto výzvy řešit, měly by se agentní benchmarky zaměřit na zajištění korelace mezi pozitivním výsledkem hodnocení a schopnostmi cílových agentů AI. Tento cíl rozložíme na dvě základní kritéria platnosti:

1. Validita úlohy: Úloha je řešitelná tehdy a pouze v případě, že agent má cílovou schopnost.

2. Validita výsledku: Výsledek hodnocení je pozitivní pouze tehdy, pokud je úkol vyřešen.

4/8

Na základě 17 populárních benchmarků (např. SWE-bench, OSWorld, TAU-bench atd.) vyvíjíme 43položkový agentic benchmark checklist (ABC), abychom rychle identifikovali, do jaké míry agent benchmark splňuje validitu úkolu a výsledku

ABECEDA:

5/8

Aplikovali jsme ABC na 10 působivých benchmarků, které byly použity k vyhodnocení o3, Gemini 2.5 a Sonnet 4. Zde je přehled našich zjištění:

1. Benchmarky 7/10 selhávají v platnosti výsledku

2. 7/10 obsahují skryté zkratky/neřešitelné úlohy

3. Pouze 2/10 zveřejňují známé problémy

Zůstaňte naladěni. Brzy zveřejníme další kvantitativní podrobnosti a opravy zjištěných problémů!

6/8

ABC umožňuje vývojářům benchmarků i modelů detekovat a opravovat nedostatky – ještě před zveřejněním výsledků.

Prozkoumejte celý kontrolní seznam, příklady a přispějte prostřednictvím našich webových stránek a úložiště GitHub ke společnému vytváření srovnávacích testů hodných hraniční umělé inteligence.

7/8

Jedná se o společnou práci s @maxYuxuanZhu, @yadapruksachatk a dalšími lidmi ze Stanfordu, Berkeley, Yale, Princetonu, MIT, Transluce, ML Commons, Amazonu a UK AISI.

8/8

21,96K

Top

Hodnocení

Oblíbené