Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

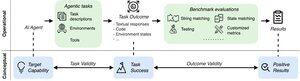

Sebagai agen AI yang mendekati penggunaan dunia nyata, bagaimana kita tahu apa yang sebenarnya dapat mereka lakukan? Tolok ukur yang andal sangat penting tetapi tolok ukur agen rusak!

Contoh: WebArena menandai "45+8 menit" pada tugas perhitungan durasi sebagai benar (jawaban nyata: "63 menit"). Tolok ukur lain salah menilai kompetensi agen sebesar 1,6-100%.

Mengapa fondasi evaluasi untuk sistem agen rapuh? Lihat di bawah untuk utas dan tautan

1/8

Evaluasi agen berbeda dari tolok ukur ML tradisional dalam hal perumusan tugas dan hasil.

Tolok ukur agen sering mengandalkan simulator rapuh (situs web mainan, database) yang berpotensi dengan bug & pintasan yang dapat memiringkan hasil. Selain itu, hasil tugas dari tolok ukur agen tidak memiliki label "emas" tetap dan seringkali perlu menilai jawaban yang tidak terstruktur (kode, panggilan API, teks panjang.)

3/8

Untuk mengatasi tantangan ini, tolok ukur agen harus bertujuan untuk memastikan korelasi antara hasil evaluasi positif dan kemampuan agen AI target. Kami menguraikan target ini menjadi dua kriteria validitas penting:

1. Validitas Tugas: Tugas dapat diselesaikan jika dan hanya jika agen memiliki kemampuan target.

2. Validitas Hasil: Hasil evaluasi positif jika dan hanya jika tugas diselesaikan.

4/8

Didasarkan pada 17 tolok ukur populer (misalnya, SWE-bench, OSWorld, TAU-bench, dll.), Kami mengembangkan daftar periksa tolok ukur agen (ABC) 43 item untuk mengidentifikasi dengan cepat sejauh mana tolok ukur agen memenuhi validitas tugas dan hasil

ABC:

5/8

Kami menerapkan ABC ke 10 tolok ukur berdampak yang digunakan untuk mengevaluasi o3, Gemini 2.5, dan Sonnet 4. Berikut adalah ikhtisar temuan kami:

1. Tolok ukur 7/10 gagal validitas hasil

2. 7/10 berisi pintasan tersembunyi/tugas yang tidak dapat dipecahkan

3. Hanya 2/10 yang mengungkapkan masalah yang diketahui

Menantikan. Kami akan segera merilis lebih banyak detail kuantitatif dan perbaikan untuk masalah yang diidentifikasi!

6/8

ABC memberdayakan pengembang benchmark & model untuk mendeteksi & memperbaiki kekurangan—sebelum hasil utama.

Jelajahi daftar periksa lengkap, contoh, dan berkontribusi melalui situs web dan repositori GitHub kami untuk membangun tolok ukur yang layak untuk AI perbatasan bersama-sama.

7/8

Ini adalah kerja sama dengan @maxYuxuanZhu, @yadapruksachatk, dan orang-orang lain dari Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon, dan UK AISI.

8/8

21,97K

Teratas

Peringkat

Favorit