Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Poiché gli agenti di intelligenza artificiale vengono utilizzati quasi nel mondo reale, come facciamo a sapere cosa possono effettivamente fare? I benchmark affidabili sono fondamentali, ma i benchmark agentici non funzionano!

Esempio: WebArena contrassegna "45+8 minuti" su un'attività di calcolo della durata come corretto (risposta reale: "63 minuti"). Altri benchmark stimano erroneamente la competenza dell'agente dell'1,6-100%.

Perché le basi di valutazione per i sistemi agentici sono fragili? Vedi sotto per thread e collegamenti

1/8

Le valutazioni agentiche differiscono dai tradizionali benchmark ML in termini di formulazione delle attività e risultati.

I benchmark agentici spesso si basano su simulatori fragili (siti Web di giocattoli, database) potenzialmente con bug e scorciatoie che possono distorcere i risultati. Inoltre, i risultati delle attività dei benchmark agentici non hanno etichette "dorate" fisse e spesso devono giudicare risposte non strutturate (codice, chiamate API, testi lunghi).

3/8

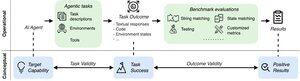

Per affrontare queste sfide, i benchmark agentici dovrebbero mirare a garantire la correlazione tra un risultato positivo della valutazione e la capacità degli agenti di IA target. Scomponiamo questo obiettivo in due criteri di validità essenziali:

1. Validità dell'attività: un'attività è risolvibile se e solo se l'agente possiede la capacità di destinazione.

2. Validità del risultato: il risultato della valutazione è positivo se e solo se il compito viene risolto.

4/8

Basandoci su 17 benchmark popolari (ad esempio, SWE-bench, OSWorld, TAU-bench, ecc.), sviluppiamo una checklist di benchmark agentico (ABC) di 43 item per identificare rapidamente in che misura un benchmark agentico soddisfa la validità del compito e del risultato

ABC:

5/8

Abbiamo applicato ABC a 10 benchmark di impatto che sono stati utilizzati per valutare o3, Gemini 2.5 e Sonnet 4. Ecco una panoramica dei nostri risultati:

1. I benchmark 7/10 non superano la validità dei risultati

2. 7/10 contiene scorciatoie nascoste/attività irrisolvibili

3. Solo 2/10 rivelano problemi noti

Restate sintonizzati. Presto rilasceremo ulteriori dettagli quantitativi e correzioni per i problemi identificati!

6/8

ABC consente agli sviluppatori di benchmark e modelli di rilevare e correggere i difetti, prima dei risultati principali.

Esplora la checklist completa, gli esempi e contribuisci tramite il nostro sito Web e il repository GitHub per creare insieme benchmark degni dell'IA di frontiera.

7/8

Questo è un lavoro congiunto con @maxYuxuanZhu, @yadapruksachatk e altre persone di Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon e UK AISI.

8/8

21,97K

Principali

Ranking

Preferiti