Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Woher wissen wir, was KI-Agenten in der Nähe des realen Einsatzes tatsächlich können? Zuverlässige Benchmarks sind entscheidend, aber agentische Benchmarks sind kaputt!

Beispiel: WebArena markiert "45+8 Minuten" in einer Dauerberechnungsaufgabe als richtig (echte Antwort: "63 Minuten"). Andere Benchmarks verschätzen die Kompetenz der Agenten um 1,6-100 %.

Warum sind die Evaluationsgrundlagen für agentische Systeme fragil? Siehe unten für Thread und Links

1/8

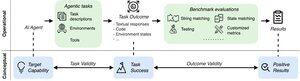

Agentische Bewertungen unterscheiden sich von herkömmlichen ML-Benchmarks in Bezug auf Aufgabenformulierung und Ergebnis.

Agentische Benchmarks stützen sich oft auf fragile Simulatoren (Spielzeug-Websites, Datenbanken), die möglicherweise Fehler und Verknüpfungen aufweisen, die die Ergebnisse verzerren können. Darüber hinaus haben die Aufgabenergebnisse von agentischen Benchmarks keine festen "goldenen" Labels und müssen oft unstrukturierte Antworten (Code, API-Aufrufe, lange Texte) beurteilen.

3/8

Um diese Herausforderungen zu bewältigen, sollten agentische Benchmarks darauf abzielen, die Korrelation zwischen einem positiven Bewertungsergebnis und der Leistungsfähigkeit der Ziel-KI-Agenten sicherzustellen. Wir zerlegen dieses Ziel in zwei wesentliche Validitätskriterien:

1. Gültigkeit der Aufgabe: Eine Aufgabe ist nur dann lösbar, wenn der Agent die Zielfähigkeit besitzt.

2. Gültigkeit des Ergebnisses: Das Evaluationsergebnis ist nur dann positiv, wenn die Aufgabe gelöst ist.

4/8

Basierend auf 17 gängigen Benchmarks (z. B. SWE-bench, OSWorld, TAU-bench, etc.) entwickeln wir eine 43 Punkte umfassende Agentic Benchmark Checklist (ABC), um schnell zu identifizieren, inwieweit ein agentischer Benchmark die Gültigkeit von Aufgaben und Ergebnissen erfüllt

ABC:

5/8

Wir haben ABC auf 10 wirkungsvolle Benchmarks angewendet, die zur Bewertung von o3, Gemini 2.5 und Sonnet 4 verwendet wurden. Hier ein Überblick über unsere Ergebnisse:

1. 7/10 Benchmarks scheitern an der Gültigkeit des Ergebnisses

2. 7/10 enthalten versteckte Abkürzungen/unlösbare Aufgaben

3. Nur 2/10 legen bekannte Probleme offen

Bleiben Sie dran. Wir werden in Kürze weitere quantitative Details und Korrekturen für die identifizierten Probleme veröffentlichen!

6/8

ABC ermöglicht es sowohl Benchmark- als auch Modellentwicklern, Fehler zu erkennen und zu beheben – bevor die Schlagzeilen in die Schlagzeilen kommen.

Erkunden Sie die vollständige Checkliste und Beispiele und tragen Sie über unsere Website und unser GitHub-Repository bei, um gemeinsam Benchmarks zu erstellen, die einer Frontier-KI würdig sind.

7/8

Dies ist eine gemeinsame Arbeit mit @maxYuxuanZhu, @yadapruksachatk und anderen Leuten aus Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon und UK AISI.

8/8

21,98K

Top

Ranking

Favoriten