Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Як ми знаємо, що вони насправді можуть робити, як агенти штучного інтелекту майже використовують у реальному світі? Надійні орієнтири мають вирішальне значення, але агентичні орієнтири зламані!

Приклад: WebArena оцінює «45+8 хвилин» у завданні на розрахунок тривалості як правильну (реальна відповідь: «63 хвилини»). Інші бенчмарки неправильно оцінюють компетентність агента на 1,6-100%.

Чому основи оцінки агентних систем є крихкими? Нижче наведено теми та посилання

1/8

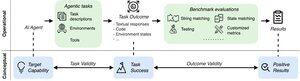

Агентні оцінки відрізняються від традиційних бенчмарків ML з точки зору формулювання завдання та результату.

Агентичні бенчмарки часто покладаються на крихкі симулятори (сайти іграшок, бази даних) потенційно з помилками та ярликами, які можуть спотворити результати. Крім того, результати завдань агентних бенчмарків не мають фіксованих «золотих» ярликів і часто потребують оцінки неструктурованих відповідей (код, виклики API, довгі тексти).

3/8

Щоб вирішити ці проблеми, агентичні орієнтири повинні бути спрямовані на забезпечення кореляції між позитивним результатом оцінки та можливостями цільових агентів ШІ. Ми розбираємо цю мету на два основні критерії валідності:

1. Валідність завдання: Завдання є вирішуваним тоді і тільки тоді, коли агент володіє цільовими можливостями.

2. Валідність результату: Результат оцінювання позитивний тоді і тільки тоді, коли завдання вирішено.

4/8

Ґрунтуючись на 17 популярних бенчмарках (наприклад, SWE-bench, OSWorld, TAU-bench тощо), ми розробляємо контрольний список агентських бенчмарків (ABC) з 43 пунктів, щоб швидко визначити, наскільки агентичний бенчмарк задовольняє обґрунтованість завдання та результату

Абетка:

5/8

Ми застосували ABC до 10 ефективних тестів, які були використані для оцінки o3, Gemini 2.5 і Sonnet 4. Ось огляд наших висновків:

1. Валідність результату помилки 7/10 бенчмарків

2. 7/10 містять приховані ярлики/нерозв'язні завдання

3. Лише 2/10 розкривають відомі проблеми

Слідкуйте за оновленнями. Незабаром ми опублікуємо більше кількісних деталей і виправлень виявлених проблем!

6/8

ABC дає можливість як розробникам еталонів, так і моделей виявляти та виправляти недоліки до того, як вони отримають заголовки результатів.

Ознайомтеся з повним контрольним списком, прикладами та зробіть свій внесок через наш веб-сайт та репозиторій GitHub, щоб разом створити тести, гідні передового штучного інтелекту.

7/8

Це спільна робота з @maxYuxuanZhu, @yadapruksachatk та іншими людьми зі Стенфорда, Берклі, Єля, Прінстона, Массачусетського технологічного інституту, Transluce, ML Commons, Amazon та UK AISI.

8/8

21,97K

Найкращі

Рейтинг

Вибране