Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Поскольку агенты ИИ приближаются к реальному использованию, откуда мы знаем, что они на самом деле могут делать? Надежные бенчмарки имеют решающее значение, но агентные бенчмарки не работают!

Пример: WebArena помечает «45+8 минут» в задаче расчета длительности как правильную (реальный ответ: «63 минуты»). Другие бенчмарки неверно оценивают компетентность агента на 1,6-100%.

Почему основания для оценки агентных систем хрупки? Смотрите ниже темы и ссылки

1/8

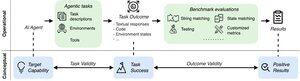

Агентные оценки отличаются от традиционных бенчмарков машинного обучения с точки зрения формулировки задачи и результата.

Агентные тесты часто полагаются на хрупкие симуляторы (игрушечные веб-сайты, базы данных), потенциально с ошибками и ярлыками, которые могут исказить результаты. Кроме того, результаты задач агентных тестов не имеют фиксированных «золотых» меток и часто нуждаются в оценке неструктурированных ответов (код, вызовы API, длинные тексты).

3/8

Чтобы решить эти проблемы, агентные бенчмарки должны быть направлены на обеспечение корреляции между положительным результатом оценки и возможностями целевых агентов ИИ. Мы разбиваем эту цель на два основных критерия валидности:

1. Валидность задачи: Задача решаема тогда и только тогда, когда агент обладает целевой способностью.

2. Валидность результата: Результат оценки является положительным тогда и только тогда, когда задача решена.

4/8

Основываясь на 17 популярных бенчмарках (например, SWE-bench, OSWorld, TAU-bench и т. д.), мы разрабатываем контрольный список из 43 пунктов агентного бенчмарка (ABC), чтобы быстро определить, в какой степени агентный бенчмарк удовлетворяет задаче и валидности результата

АЗБУКА:

5/8

Мы применили ABC к 10 значимым бенчмаркам, которые использовались для оценки o3, Gemini 2.5 и Sonnet 4. Вот обзор наших выводов:

1. 7 из 10 контрольных показателей не соответствуют валидности результатов

2. 7/10 содержат скрытые ярлыки/нерешаемые задачи

3. Только 2/10 раскрывают известные проблемы

Оставайтесь с нами. В ближайшее время мы опубликуем больше количественных данных и исправлений для выявленных проблем!

6/8

ABC дает возможность разработчикам бенчмарков и моделей обнаруживать и исправлять недостатки до того, как появятся первые результаты.

Изучите полный контрольный список, примеры и внесите свой вклад через наш веб-сайт и репозиторий GitHub, чтобы вместе создать бенчмарки, достойные передового ИИ.

7/8

Это совместная работа с @maxYuxuanZhu, @yadapruksachatk и другими ребятами из Стэнфорда, Беркли, Йеля, Принстона, Массачусетского технологического института, Transluce, ML Commons, Amazon и UK AISI.

8/8

22,02K

Топ

Рейтинг

Избранное