Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

A medida que los agentes de IA se acercan al uso en el mundo real, ¿cómo sabemos lo que realmente pueden hacer? Los puntos de referencia confiables son críticos, ¡pero los puntos de referencia agentic están rotos!

Ejemplo: WebArena marca "45+8 minutos" en una tarea de cálculo de duración como correcta (respuesta real: "63 minutos"). Otros puntos de referencia subestiman la competencia de los agentes entre un 1,6 y un 100%.

¿Por qué son frágiles los fundamentos de evaluación de los sistemas agénticos? Vea a continuación el hilo y los enlaces

1/8

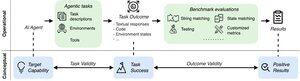

Las evaluaciones agenciales difieren de los puntos de referencia tradicionales de ML en términos de formulación de tareas y resultados.

Los puntos de referencia de Agentic a menudo se basan en simuladores frágiles (sitios web de juguetes, bases de datos) potencialmente con errores y atajos que pueden sesgar los resultados. Además, los resultados de las tareas de los puntos de referencia agenciales no tienen etiquetas fijas de "oro" y, a menudo, necesitan juzgar respuestas no estructuradas (código, llamadas a la API, textos largos).

3/8

Para abordar estos desafíos, los puntos de referencia agenciales deben tener como objetivo garantizar la correlación entre un resultado de evaluación positivo y la capacidad de los agentes de IA objetivo. Descomponemos este objetivo en dos criterios de validez esenciales:

1. Validez de la tarea: Una tarea se puede resolver si y solo si el agente posee la capacidad objetivo.

2. Validez del resultado: El resultado de la evaluación es positivo si y solo si se resuelve la tarea.

4/8

Basado en 17 puntos de referencia populares (por ejemplo, SWE-bench, OSWorld, TAU-bench, etc.), desarrollamos una lista de verificación de referencia agencial (ABC) de 43 ítems para identificar rápidamente hasta qué punto un punto de referencia agencial satisface la validez de la tarea y el resultado

ABECEDARIO:

5/8

Aplicamos ABC a 10 puntos de referencia impactantes que se utilizaron para evaluar o3, Gemini 2.5 y Sonnet 4. Aquí hay una descripción general de nuestros hallazgos:

1. 7/10 puntos de referencia fallan en la validez del resultado

2. 7/10 contienen atajos ocultos / tareas irresolubles

3. Solo 2/10 revelan problemas conocidos

Estén atentos. ¡Pronto publicaremos más detalles cuantitativos y correcciones para los problemas identificados!

6/8

ABC permite a los desarrolladores de modelos y de referencia detectar y corregir fallas, antes de los resultados principales.

Explore la lista de verificación completa, los ejemplos y contribuya a través de nuestro sitio web y el repositorio de GitHub para crear juntos puntos de referencia dignos de la IA de frontera.

7/8

Este es un trabajo conjunto con @maxYuxuanZhu, @yadapruksachatk y otras personas de Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon y UK AISI.

8/8

21.98K

Populares

Ranking

Favoritas