Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hoe weten we wat ze daadwerkelijk kunnen doen, nu AI-agenten in de buurt van real-world worden gebruikt? Betrouwbare benchmarks zijn van cruciaal belang, maar agentische benchmarks zijn verbroken!

Voorbeeld: WebArena markeert "45+8 minuten" op een duurberekeningstaak als correct (echt antwoord: "63 minuten"). Andere benchmarks schatten de competentie van agenten met 1,6-100% verkeerd in.

Waarom zijn de evaluatiefundamenten voor agentische systemen kwetsbaar? Zie hieronder voor thread en links

1/8

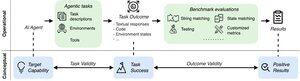

Agentische evaluaties verschillen van traditionele ML-benchmarks in termen van taakformulering en resultaat.

Agentische benchmarks zijn vaak afhankelijk van fragiele simulatoren (speelgoedwebsites, databases) die mogelijk bugs en snelkoppelingen bevatten die de resultaten kunnen vertekenen. Bovendien hebben taakresultaten van agentische benchmarks geen vaste "gouden" labels en moeten ze vaak ongestructureerde antwoorden beoordelen (code, API-aanroepen, lange teksten).

3/8

Om deze uitdagingen aan te gaan, moeten agentische benchmarks gericht zijn op het waarborgen van de correlatie tussen een positief evaluatieresultaat en het vermogen van de beoogde AI-agenten. We ontleden dit doel in twee essentiële validiteitscriteria:

1. Taakvaliditeit: Een taak is oplosbaar als en slechts dan als de agent over de doelcapaciteit beschikt.

2. Outcome Validity: Het evaluatieresultaat is positief als en alleen als de taak is opgelost.

4/8

Gebaseerd op 17 populaire benchmarks (bijv. SWE-bench, OSWorld, TAU-bench, enz.), ontwikkelen we een agentische benchmarkchecklist (ABC) met 43 items om snel te identificeren in hoeverre een agentische benchmark voldoet aan de validiteit van taken en resultaten

ABC:

5/8

We hebben ABC toegepast op 10 impactvolle benchmarks die werden gebruikt om o3, Gemini 2.5 en Sonnet 4 te evalueren. Hier is een overzicht van onze bevindingen:

1. 7/10 benchmarks zijn niet geldig voor de uitkomst

2. 7/10 bevatten verborgen snelkoppelingen/onoplosbare taken

3. Slechts 2/10 maakt bekende problemen bekend

Blijf kijken. We zullen binnenkort meer kwantitatieve details en oplossingen vrijgeven voor de geïdentificeerde problemen!

6/8

ABC stelt zowel benchmark- als modelontwikkelaars in staat om fouten te detecteren en op te lossen - voordat de resultaten worden gepubliceerd.

Bekijk de volledige checklist, voorbeelden en draag bij via onze website en GitHub-repo om samen benchmarks te bouwen die grensverleggende AI waardig zijn.

7/8

Dit is een gezamenlijk werk met @maxYuxuanZhu, @yadapruksachatk en andere mensen van Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon en UK AISI.

8/8

22,03K

Boven

Positie

Favorieten