Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

En tant qu’agents d’IA utilisant presque le monde réel, comment savons-nous ce qu’ils peuvent réellement faire ? Les benchmarks fiables sont essentiels, mais les benchmarks agentiques sont cassés !

Exemple : WebArena marque « 45+8 minutes » sur une tâche de calcul de durée comme correcte (réponse réelle : « 63 minutes »). D’autres points de référence évaluent mal la compétence des agents de 1,6 à 100 %.

Pourquoi les fondements de l’évaluation des systèmes agentiques sont-ils fragiles ? Voir ci-dessous pour le fil de discussion et les liens

1/8

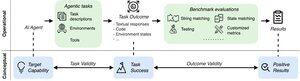

Les évaluations agentiques diffèrent des benchmarks ML traditionnels en termes de formulation et de résultat des tâches.

Les benchmarks agentiques s’appuient souvent sur des simulateurs fragiles (sites web de jouets, bases de données) potentiellement avec des bugs et des raccourcis qui peuvent fausser les résultats. De plus, les résultats des benchmarks agentiques n’ont pas d’étiquettes « dorées » fixes et doivent souvent juger des réponses non structurées (code, appels API, textes longs).

3/8

Pour relever ces défis, les benchmarks agentiques doivent viser à assurer la corrélation entre un résultat d’évaluation positif et la capacité des agents d’IA cibles. Nous décomposons cet objectif en deux critères de validité essentiels :

1. Validité de la tâche : Une tâche peut être résolue si et seulement si l’agent possède la capacité cible.

2. Validité du résultat : Le résultat de l’évaluation est positif si et seulement si la tâche est résolue.

4/8

Sur la base de 17 benchmarks populaires (par exemple, SWE-bench, OSWorld, TAU-bench, etc.), nous développons une liste de contrôle de référence agentique (ABC) de 43 éléments pour identifier rapidement dans quelle mesure un benchmark agentique satisfait à la validité de la tâche et du résultat

ABC:

5/8

Nous avons appliqué ABC à 10 benchmarks percutants qui ont été utilisés pour évaluer o3, Gemini 2.5 et Sonnet 4. Voici un aperçu de nos résultats :

1. Les benchmarks 7/10 échouent à la validité du résultat

2. 7/10 contiennent des raccourcis cachés/tâches insolubles

3. Seulement 2/10 divulguent les problèmes connus

Restez à l’écoute. Nous publierons bientôt plus de détails quantitatifs et de correctifs pour les problèmes identifiés !

6/8

ABC permet aux développeurs de benchmarks et de modèles de détecter et de corriger les défauts, avant les résultats globaux.

Explorez la liste de contrôle complète, des exemples et contribuez via notre site Web et notre dépôt GitHub pour créer ensemble des benchmarks dignes de l’IA de pointe.

7/8

Il s’agit d’un travail conjoint avec @maxYuxuanZhu, @yadapruksachatk et d’autres personnes de Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon et UK AISI.

8/8

21,98K

Meilleurs

Classement

Favoris