Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Skoro agenci SI są niemal w realnym użyciu, skąd wiemy, co tak naprawdę potrafią? Wiarygodne testy porównawcze mają kluczowe znaczenie, ale testy agentów są zepsute!

Przykład: WebArena oznacza "45 + 8 minut" w zadaniu obliczania czasu trwania jako poprawne (prawdziwa odpowiedź: "63 minuty"). Inne benchmarki błędnie szacują kompetencje agentów o 1,6-100%.

Dlaczego podstawy oceny systemów agentowych są kruche? Zobacz poniżej wątek i linki

1/8

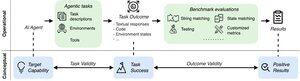

Oceny agentyczne różnią się od tradycyjnych testów porównawczych uczenia maszynowego pod względem formułowania zadań i wyników.

Testy porównawcze często opierają się na delikatnych symulatorach (stronach internetowych z zabawkami, bazach danych) potencjalnie z błędami i skrótami, które mogą zniekształcić wyniki. Co więcej, wyniki testów porównawczych agentów nie mają ustalonych "złotych" etykiet i często muszą oceniać nieustrukturyzowane odpowiedzi (kod, wywołania API, długie teksty).

3/8

Aby sprostać tym wyzwaniom, agentyczne wskaźniki referencyjne powinny mieć na celu zapewnienie korelacji między pozytywnym wynikiem oceny a zdolnościami docelowych agentów SI. Cel ten rozkładamy na dwa zasadnicze kryteria trafności:

1. Ważność zadania: Zadanie można rozwiązać wtedy i tylko wtedy, gdy agent posiada docelową zdolność.

2. Trafność wyniku: Wynik oceny jest pozytywny wtedy i tylko wtedy, gdy zadanie zostanie rozwiązane.

4/8

Opierając się na 17 popularnych testach porównawczych (np. SWE-bench, OSWorld, TAU-bench itp.), opracowujemy 43-elementową listę kontrolną agentic benchmark (ABC), aby szybko określić, w jakim stopniu agent benchmark spełnia ważność zadania i wyniku

ABECADŁO:

5/8

Zastosowaliśmy ABC do 10 wpływowych testów porównawczych, które zostały wykorzystane do oceny o3, Gemini 2.5 i Sonnet 4. Oto przegląd naszych ustaleń:

1. Testy porównawcze 7/10 nie dają ważności wyników

2. 7/10 zawiera ukryte skróty/nierozwiązywalne zadania

3. Tylko 2/10 ujawnia znane problemy

Stay tuned. Wkrótce opublikujemy więcej szczegółów ilościowych i poprawek zidentyfikowanych błędów!

6/8

ABC umożliwia zarówno twórcom testów porównawczych, jak i modeli wykrywanie i naprawianie błędów - przed uzyskaniem głównych wyników.

Zapoznaj się z pełną listą kontrolną, przykładami i wnieś swój wkład za pośrednictwem naszej witryny internetowej i repozytorium GitHub, aby wspólnie tworzyć testy porównawcze godne pionierskiej sztucznej inteligencji.

7/8

Jest to wspólna praca z @maxYuxuanZhu, @yadapruksachatk i innymi ludźmi ze Stanford, Berkeley, Yale, Princeton, MIT, Transluce, ML Commons, Amazon i UK AISI.

8/8

21,98K

Najlepsze

Ranking

Ulubione