トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

AI エージェントが現実世界で使用されるのに近い場合、実際に何ができるかをどうやって知ることができるのでしょうか?信頼できるベンチマークは重要ですが、エージェントのベンチマークは破られます。

例: WebArena は、期間計算タスクで「45+8 分」を正解としてマークします (実際の答え: 「63 分」)。他のベンチマークでは、エージェントの能力が1.6〜100%誤って推定されています。

エージェントシステムの評価基盤が脆弱なのはなぜですか?スレッドとリンクについては以下を参照してください

1/8

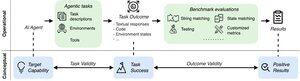

エージェント評価は、タスクの定式化と結果の点で従来の ML ベンチマークとは異なります。

エージェントベンチマークは、多くの場合、壊れやすいシミュレーター(おもちゃのWebサイト、データベース)に依存しており、結果を歪める可能性のあるバグやショートカットがある可能性があります。さらに、エージェントベンチマークのタスク結果には固定された「ゴールド」ラベルがなく、多くの場合、構造化されていない回答(コード、API呼び出し、長いテキスト)を判断する必要があります。

3/8

これらの課題に対処するために、エージェントベンチマークは、肯定的な評価結果とターゲットAIエージェントの能力との相関関係を確保することを目指す必要があります。このターゲットを2つの重要な妥当性基準に分解します。

1. タスクの妥当性: エージェントがターゲット機能を備えている場合にのみ、タスクを解決できます。

2. 結果の妥当性: タスクが解決された場合にのみ、評価結果は肯定的です。

4/8

17の一般的なベンチマーク(SWE-bench、OSWorld、TAU-benchなど)に基づいて、エージェントベンチマークがタスクと結果の妥当性をどの程度満たしているかを迅速に特定するために、43項目のエージェントベンチマークチェックリスト(ABC)を開発します

甲乙丙:

5/8

o3、Gemini 2.5、Sonnet 4 の評価に使用された 10 の影響力のあるベンチマークに ABC を適用しました。調査結果の概要は次のとおりです。

1. 7/10ベンチマークは結果の妥当性に失敗します

2. 7/10には隠されたショートカット/解決できないタスクが含まれています

3. 既知の問題を開示するのは 2/10 のみ

乞うご期待。特定された問題に対する定量的な詳細と修正を間もなくリリースします。

6/8

ABCは、ベンチマーク開発者とモデル開発者の両方が、ヘッドラインの結果の前に欠陥を検出して修正できるようにします。

完全なチェックリストと例を調べ、当社の Web サイトと GitHub リポジトリを通じて貢献して、フロンティア AI にふさわしいベンチマークを一緒に構築してください。

7/8

これは、スタンフォード大学、バークレー大学、イェール大学、プリンストン大学、マサチューセッツ工科大学、Transluce、ML Commons、Amazon、英国AISIの@maxYuxuanZhu、@yadapruksachatk、その他の人々との共同研究です。

8/8

21.97K

トップ

ランキング

お気に入り