Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Daniel Kang

Asistent profesora na UIUC CS. Dříve působil ve Stanfordské laboratoři DAWN a v Berkeley Sky Lab.

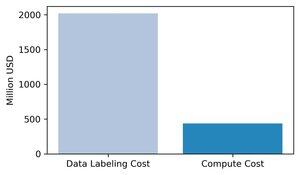

Převládá názor, že výpočetní technika je nejdůležitějším faktorem pro trénink hraniční umělé inteligence. Myslíme si, že je to špatně: data jsou nejnákladnější a nejdůležitější součástí školení AI.

Shromáždili jsme odhady výnosů hlavních společností zabývajících se označováním dat a porovnali je s mezními výpočetními náklady na trénování špičkových modelů v roce 2024. Naše odhady ukazují, že označování dat je ~3x vyšší než okrajový trénovací výpočet.

1/8

140,98K

Vyhráli jsme první místo na summitu Berkeley AgentX za benchmarky a hodnocení! Gratulujeme týmu :)

Daniel Kang9. 7. 2025

Jak můžeme vědět, co jako agenti umělé inteligence téměř v reálném světě dokážou? Spolehlivé benchmarky jsou kritické, ale agentické benchmarky jsou nefunkční!

Příklad: WebArena označí "45+8 minut" v úloze výpočtu doby trvání jako správnou (skutečná odpověď: "63 minut"). Jiné benchmarky nesprávně odhadují kompetenci agenta o 1,6-100 %.

Proč jsou základy hodnocení agentických systémů křehké? Vlákno a odkazy naleznete níže

1/8

980

Jsem špatný v posílání věcí včas! (moje omluva je, že letos opět učím v Addis Coderu)

Posterová sekce pro tento článek probíhá PRÁVĚ TEĎ!

Session5: V-Collect Najít 28.7.2025 18:00-19:30

Pozdravte @ChuxuanHu :)

Daniel Kang29. 7. 2025

Mohou agenti umělé inteligence posoudit reprodukovatelnost výsledků výzkumu?

Náš #ACL2025 článek ukazuje, že zaostávají za REPRO-Bench, novým benchmarkem, který hodnotí agenty v reálných úlohách reprodukovatelnosti společenských věd ze 112 článků, plných PDF, kódu a dat. Náš nejvýkonnější agent má skóre <40 %!

1/6

2,71K

Mohou agenti umělé inteligence posoudit reprodukovatelnost výsledků výzkumu?

Náš #ACL2025 článek ukazuje, že zaostávají za REPRO-Bench, novým benchmarkem, který hodnotí agenty v reálných úlohách reprodukovatelnosti společenských věd ze 112 článků, plných PDF, kódu a dat. Náš nejvýkonnější agent má skóre <40 %!

1/6

6,69K

SWE-bench Verified je zlatý standard pro hodnocení kódovacích agentů: 500 problémů z reálného světa + testy od OpenAI. Zní to neprůstřelně? Skoro.

Ukážeme, že prošel jeho jednotkovými testy != odpovídající základní pravdivost. V našem dokumentu ACL jsme opravili chybné evaly: 24 % agentů se posunulo nahoru nebo dolů v žebříčku!

1/7

24,97K

Budu prezentovat na posterové sekci 2 na SIGMOD (středa 16:00 v Postupimi II). Přijďte vás pozdravit!

Daniel Kang24. 6. 2025

Přibližné zpracování dotazů (AQP) může řádově zrychlit dlouhotrvající analytické dotazy. Proč je ale AQP ve výrobě stále vzácný?

Abychom to vyřešili, vyvíjíme PilotDB, online AQP střed, který provádí 0 změn v DBMS, poskytuje výsledky s apriorními zárukami chyb a dosahuje až 126x zrychlení.

1/8

745

@ZhanQiusi1 budeme prezentovat naši práci ve středu v 11 hodin a na sobotním workshopu TrustNLP (spotlight talk)! Pozdrav, pokud ji uvidíš

Daniel Kang13. 3. 2025

Agenti umělé inteligence jsou stále populárnější (např. operátor OpenAI), ale mohou být napadeni a poškodit uživatele!

V našem dokumentu o zjištěních NAACL 2025 ukazujeme, že i s obranou mohou být agenti umělé inteligence stále kompromitováni prostřednictvím nepřímých promptních injekcí prostřednictvím "adaptivních útoků"

🧵 a odkazy níže

208

Top

Hodnocení

Oblíbené

Co je v trendu on-chain

Populární na X

Nejvyšší finanční vklady v poslední době

Nejpozoruhodnější