Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Daniel Kang

Asst. professor ved UIUC CS. Tidligere i Stanford DAWN-laboratoriet og Berkeley Sky Lab.

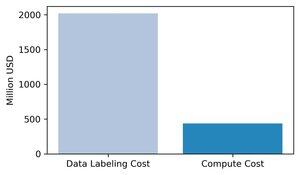

Den rådende visdommen er at databehandling er den viktigste faktoren for grensebasert AI-trening. Vi mener dette er feil: data er den mest kostbare og viktige komponenten i AI-trening.

Vi samlet inn estimater av inntekter for store datamerkingsselskaper og sammenlignet dem med den marginale databehandlingskostnaden for opplæring av toppmodeller i 2024. Våre estimater viser at datamerking er ~3 ganger høyere enn den marginale treningsberegningen.

1/8

145K

Vi vant førsteplassen på Berkeley AgentX-toppmøtet for benchmarks og evalueringssporet! Gratulerer til teamet :)

Daniel Kang9. juli 2025

Når AI-agenter nærmer seg bruk i den virkelige verden, hvordan vet vi hva de faktisk kan gjøre? Pålitelige benchmarks er kritiske, men agentiske benchmarks er brutt!

Eksempel: WebArena markerer "45+8 minutter" på en varighetsberegningsoppgave som riktig (reelt svar: "63 minutter"). Andre referanseindekser feilestimerer agentkompetanse med 1,6-100 %.

Hvorfor er evalueringsgrunnlaget for agentiske systemer skjøre? Se nedenfor for tråd og lenker

1/8

984

Jeg er dårlig til å legge ut ting i tide! (unnskyldningen min er at jeg underviser ved Addis Coder igjen i år)

Postersesjonen for denne artikkelen skjer AKKURAT NÅ!

Sesjon 5: V-Gather Finn 28.07.2025 18:00-19:30

Si hei til @ChuxuanHu :)

Daniel Kang29. juli 2025

Kan AI-agenter vurdere reproduserbarheten til forskningsresultater?

Vår #ACL2025 artikkel viser at de kommer til kort med REPRO-Bench, en ny målestokk som evaluerer agenter på virkelige samfunnsvitenskapelige reproduserbarhetsoppgaver på 112 artikler, fullstendige PDF-er, kode og data. Vår best presterende agent scorer <40%!

1/6

2,72K

Kan AI-agenter vurdere reproduserbarheten til forskningsresultater?

Vår #ACL2025 artikkel viser at de kommer til kort med REPRO-Bench, en ny målestokk som evaluerer agenter på virkelige samfunnsvitenskapelige reproduserbarhetsoppgaver på 112 artikler, fullstendige PDF-er, kode og data. Vår best presterende agent scorer <40%!

1/6

6,7K

SWE-bench Verified er gullstandarden for evaluering av kodeagenter: 500 virkelige problemer + tester av OpenAI. Høres skuddsikkert ut? Bortimot.

Vi viser å bestå enhetstestene != samsvarende grunnsannhet. I ACL-artikkelen vår fikset vi buggy-vurderinger: 24 % av agentene flyttet opp eller ned på ledertavlen!

1/7

24,97K

Jeg skal presentere på postersesjon 2 på SIGMOD (onsdag 16:00 i Potsdam II). Kom og si hei!

Daniel Kang24. juni 2025

Omtrentlig spørringsbehandling (AQP) kan akselerere langvarige analytiske spørringer etter størrelsesordener. Men hvorfor er AQP fortsatt sjelden i produksjon?

For å løse det utvikler vi PilotDB, en online AQP-midte som gjør 0 endringer i DBMS-er, leverer resultater med a priori feilgarantier og oppnår opptil 126x hastighet.

1/8

749

Omtrentlig spørringsbehandling (AQP) kan akselerere langvarige analytiske spørringer etter størrelsesordener. Men hvorfor er AQP fortsatt sjelden i produksjon?

For å løse det utvikler vi PilotDB, en online AQP-midte som gjør 0 endringer i DBMS-er, leverer resultater med a priori feilgarantier og oppnår opptil 126x hastighet.

1/8

1,64K

@ZhanQiusi1 vil presentere arbeidet vårt på onsdag kl. 11 plakatsesjon og lørdagens TrustNLP-workshop (spotlight talk)! Si hei hvis du ser henne

Daniel Kang13. mars 2025

AI-agenter blir stadig mer populære (f.eks. OpenAIs operatør), men kan angripes for å skade brukere!

Vi viser at selv med forsvar kan AI-agenter fortsatt bli kompromittert via indirekte raske injeksjoner via "adaptive angrep" i vår NAACL 2025-funnartikkel

🧵 og lenker nedenfor

212

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til