Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Daniel Kang

Professore associato presso UIUC CS. Precedentemente nel laboratorio DAWN di Stanford e nel Berkeley Sky Lab.

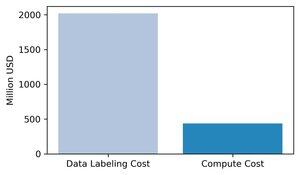

La saggezza prevalente è che il calcolo sia il fattore più importante per l'addestramento dell'IA di frontiera. Pensiamo che questo sia sbagliato: i dati sono il componente più costoso e importante dell'addestramento dell'IA.

Abbiamo raccolto stime di fatturato per le principali aziende di etichettatura dei dati e le abbiamo confrontate con il costo marginale del calcolo per l'addestramento dei modelli di punta nel 2024. Le nostre stime mostrano che l'etichettatura dei dati è ~3 volte superiore al costo marginale del calcolo per l'addestramento.

1/8

145K

Abbiamo vinto il primo posto al summit Berkeley AgentX per il track di benchmark e valutazioni! Congratulazioni al team :)

Daniel Kang9 lug 2025

As AI agents near real-world use, how do we know what they can actually do? Reliable benchmarks are critical but agentic benchmarks are broken!

Example: WebArena marks "45+8 minutes" on a duration calculation task as correct (real answer: "63 minutes"). Other benchmarks misestimate agent competence by 1.6-100%.

Why are the evaluation foundations for agentic systems fragile? See below for thread and links

1/8

986

Sono scarso a pubblicare le cose in tempo! (la mia scusa è che insegno di nuovo all'Addis Coder quest'anno)

La sessione di poster per questo articolo sta avvenendo PROPRIO ORA!

Sessione5: V-Gather Trova 28/07/2025 18:00-19:30

Saluta @ChuxuanHu :)

Daniel Kang29 lug 2025

Can AI agents assess the reproducibility of research findings?

Our #ACL2025 paper shows that they fall short with REPRO-Bench, a new benchmark that evaluates agents on real-world social science reproducibility tasks of 112 papers, full PDFs, code, and data. Our highest performing agent scores <40%!

1/6

2,72K

Gli agenti AI possono valutare la riproducibilità dei risultati della ricerca?

Il nostro articolo per #ACL2025 mostra che non ci riescono con REPRO-Bench, un nuovo benchmark che valuta gli agenti su compiti di riproducibilità delle scienze sociali nel mondo reale, basati su 112 articoli, PDF completi, codice e dati. Il nostro agente con le migliori prestazioni ottiene meno del 40%!

1/6

6,7K

SWE-bench Verified è lo standard d'oro per valutare gli agenti di codifica: 500 problemi reali + test di OpenAI. Sembra a prova di proiettile? Non proprio.

Mostriamo che superare i suoi test unitari != corrispondere alla verità di base. Nel nostro articolo ACL, abbiamo corretto valutazioni difettose: il 24% degli agenti è salito o sceso nella classifica!

1/7

24,97K

L'apprendimento per rinforzo consente ai LLM di battere gli esseri umani nelle competizioni di programmazione/matematica e ha guidato i recenti progressi (la serie o di OpenAI, Claude 4 di Anthropic)

L'apprendimento per rinforzo permetterà una generalizzazione ampia nello stesso modo in cui lo fa il pre-addestramento? Non con le tecniche attuali

🧵 1/7

2,7K

Presenterò alla sessione poster 2 al SIGMOD (mercoledì 16:00 a Potsdam II). Vieni a salutarci!

Daniel Kang24 giu 2025

Il processamento delle query approssimative (AQP) può accelerare le query analitiche a lungo termine di ordini di grandezza. Ma perché l'AQP è ancora raro in produzione?

Per affrontare questo problema, sviluppiamo PilotDB, un middleware AQP online che non apporta modifiche ai DBMS, fornisce risultati con garanzie di errore a priori e raggiunge un'accelerazione fino a 126 volte.

1/8

750

Il processamento delle query approssimative (AQP) può accelerare le query analitiche a lungo termine di ordini di grandezza. Ma perché l'AQP è ancora raro in produzione?

Per affrontare questo problema, sviluppiamo PilotDB, un middleware AQP online che non apporta modifiche ai DBMS, fornisce risultati con garanzie di errore a priori e raggiunge un'accelerazione fino a 126 volte.

1/8

1,64K

@ZhanQiusi1 presenteremo il nostro lavoro alla sessione poster del mercoledì alle 11 del mattino e al workshop TrustNLP del sabato (spotlight talk)! Saluta se la vedi

Daniel Kang13 mar 2025

AI agents are increasingly popular (e.g., OpenAI's operator) but can be attacked to harm users!

We show that even with defenses, AI agents can still be compromised via indirect prompt injections via "adaptive attacks" in our NAACL 2025 findings paper

🧵 and links below

213

Principali

Ranking

Preferiti

On-chain di tendenza

Di tendenza su X

Principali fondi recenti

Più popolari