Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

HØYKONJUNKTUR! STOR AI-HASTIGHET!

Hot Rod AI 100 ganger raskere slutning 100 000 ganger mindre kraft!

—

Gjenoppliving av analoge kretser: Et sprang mot ultraeffektiv AI med oppmerksomhet i minnet

Jeg begynte med analog elektronikk da jeg var liten og trodde alltid at analoge datamaskiner ville gjøre comeback. Analog databehandling av nevrale nettverk på 1960-tallet brukte spenningsbaserte kretser i stedet for binære klokker.

Analog er raskere enn digital

Store språkmodeller i kjernen ligger transformatorarkitekturen, der selvoppmerksomhetsmekanismer siler gjennom enorme sekvenser av data for å forutsi neste ord eller token.

På konvensjonelle GPU-er sluker transport av data mellom minnebuffere og prosessorenheter tid og energi, og flaskehalser hele systemet. De krever en klokkesyklus for nøyaktig å flytte biter inn og ut av minne og registre, og dette er >90 % av tiden og energien.

Men nå foreslår en banebrytende studie et tilpasset databehandlingsoppsett i minnet som kan redusere denne ineffektiviteten, og potensielt omforme hvordan vi distribuerer generativ AI.

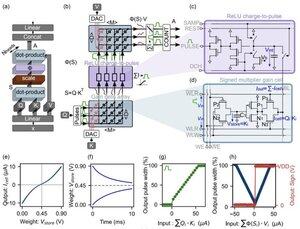

Innovasjonen sentrerer seg om "gain cells" – nye ladningsbaserte analoge minner som fungerer som både lagrings- og beregningsmotorer.

I motsetning til digitale GPUer, som møysommelig laster token-projeksjoner fra cache til SRAM for hvert generasjonstrinn, holder denne arkitekturen data der matematikken skjer: rett på brikken! Med en klokkehastighet nær LYSETS HASTIGHET fordi den aldri er på/av som i digital binær.

Ved å utnytte parallelle analoge punktproduktoperasjoner, beregner designet selvoppmerksomhet naturlig, og omgår databevegelsen som plager GPU-maskinvare.

For å bygge bro mellom ideelle digitale modeller og de støyende realitetene til analoge kretser, utviklet forskerne en smart initialiseringsalgoritme.

Denne metoden tilpasser forhåndstrente LLM-er, for eksempel GPT-2, uten behov for full omskolering, og sikrer sømløs ytelsesparitet til tross for ikke-idealiteter som spenningsdrift eller presisjonsgrenser.

Resultatene er intet mindre enn svimlende!

...

Topp

Rangering

Favoritter