Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BOOM ! ACCÉLÉRATION MAJEURE DE L'IA !

Hot Rod AI 100 fois plus rapide en inférence, 100 000 fois moins de puissance !

—

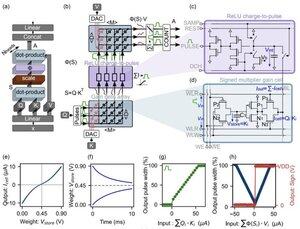

Renaissance des Circuits Analogiques : Un Saut Vers une IA Ultra-Efficace avec Attention en Mémoire

J'ai commencé dans l'électronique analogique quand j'étais enfant et j'ai toujours pensé que les ordinateurs analogiques feraient un retour. L'informatique analogique des réseaux de neurones des années 1960 utilisait des circuits basés sur la tension plutôt que des horloges binaires.

L'Analogique est Plus Rapide que le Numérique

Au cœur des grands modèles de langage se trouve l'architecture des transformateurs, où les mécanismes d'auto-attention trient d'énormes séquences de données pour prédire le prochain mot ou jeton.

Sur des GPU conventionnels, le transfert de données entre les caches mémoire et les unités de traitement consomme du temps et de l'énergie, créant un goulot d'étranglement pour l'ensemble du système. Ils nécessitent un cycle d'horloge pour déplacer précisément les bits dans et hors de la mémoire et des registres, et cela représente plus de 90 % du temps et de l'énergie dépensés.

Mais maintenant, une étude révolutionnaire propose une configuration de calcul en mémoire sur mesure qui pourrait réduire ces inefficacités, remodelant potentiellement la façon dont nous déployons l'IA générative.

L'innovation se concentre sur les "cellules de gain" — des mémoires analogiques basées sur la charge émergentes qui font à la fois office de stockage et de moteurs de calcul.

Contrairement aux GPU numériques, qui chargent laborieusement les projections de jetons du cache vers la SRAM pour chaque étape de génération, cette architecture garde les données là où les calculs se produisent : directement SUR LA PUCE ! Avec une vitesse d'horloge proche de LA VITESSE DE LA LUMIÈRE car elle n'est jamais allumée/éteinte comme dans le binaire numérique.

En tirant parti des opérations de produit scalaire analogiques parallèles, la conception calcule l'auto-attention de manière native, contournant le mouvement de données qui afflige le matériel GPU.

Pour combler le fossé entre les modèles numériques idéaux et les réalités bruyantes des circuits analogiques, les chercheurs ont conçu un algorithme d'initialisation astucieux.

Cette méthode adapte les LLM pré-entraînés, tels que GPT-2, sans avoir besoin d'un réentraînement complet, garantissant une parité de performance sans faille malgré des non-idéalités comme les dérives de tension ou les limites de précision.

Les résultats sont tout simplement stupéfiants !

...

Meilleurs

Classement

Favoris