Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BOOM! PERCEPATAN AI UTAMA!

Hot Rod AI inferensi 100 kali lebih cepat 100.000 kali lebih sedikit daya!

—

Menghidupkan Kembali Sirkuit Analog: Lompatan Menuju AI Ultra-Efisien dengan Perhatian Dalam Memori

Saya memulai penelitian saya di bidang elektronik analog ketika saya masih kecil dan selalu berpikir komputer analog akan kembali. Komputasi analog jaringan saraf tahun 1960-an menggunakan sirkuit berbasis tegangan daripada jam biner.

Analog Lebih Cepat Dari Digital

Model bahasa besar pada intinya terletak pada arsitektur transformator, di mana mekanisme perhatian diri menyaring urutan data yang luas untuk memprediksi kata atau token berikutnya.

Pada GPU konvensional, bolak-balik data antara cache memori dan unit pemrosesan menghabiskan waktu dan energi, sehingga menghambat seluruh sistem. Mereka membutuhkan siklus jam untuk memindahkan bit masuk dan keluar dari memori dan register secara tepat dan ini adalah >90% dari waktu dan energi overhead.

Tetapi sekarang sebuah studi inovatif mengusulkan pengaturan komputasi dalam memori khusus yang dapat memangkas inefisiensi ini, berpotensi membentuk kembali cara kita menerapkan AI generatif.

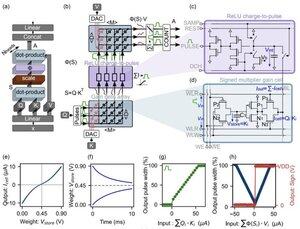

Inovasi ini berpusat pada "sel penguatan"—memori analog berbasis muatan yang muncul yang berfungsi ganda sebagai mesin penyimpanan dan komputasi.

Tidak seperti GPU digital, yang dengan susah payah memuat proyeksi token dari cache ke SRAM untuk setiap langkah generasi, arsitektur ini menyimpan data di mana matematika terjadi: tepat PADA CHIP! Dengan kecepatan clock mendekati THE SPEED OF LIGHT karena tidak pernah on/off seperti di biner digital.

Dengan memanfaatkan operasi produk titik analog paralel, desain menghitung perhatian diri secara asli, menghindari pergerakan data yang mengganggu perangkat keras GPU.

Untuk menjembatani kesenjangan antara model digital yang ideal dan realitas sirkuit analog yang bising, para peneliti merancang algoritma inisialisasi yang cerdas.

Metode ini mengadaptasi LLM yang telah dilatih sebelumnya, seperti GPT-2, tanpa perlu pelatihan ulang penuh, memastikan paritas kinerja yang mulus meskipun tidak ada idealitas seperti penyimpangan tegangan atau batas presisi.

Hasilnya sangat mengejutkan!

...

Teratas

Peringkat

Favorit