Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

¡BOOM! ¡ACELERACIÓN MAYOR DE IA!

¡Hot Rod AI 100 veces más rápido en inferencia y 100,000 veces menos consumo de energía!

—

Reviviendo Circuitos Analógicos: Un Salto Hacia una IA Ultra-Eficiente con Atención en Memoria

Comencé en la electrónica analógica cuando era niño y siempre pensé que las computadoras analógicas volverían. La computación analógica de las redes neuronales de los años 60 utilizaba circuitos basados en voltaje en lugar de relojes binarios.

El Analógico es Más Rápido que el Digital

En el núcleo de los grandes modelos de lenguaje se encuentra la arquitectura del transformador, donde los mecanismos de autoatención examinan vastas secuencias de datos para predecir la siguiente palabra o token.

En las GPU convencionales, el transporte de datos entre cachés de memoria y unidades de procesamiento consume tiempo y energía, creando un cuello de botella en todo el sistema. Requieren un ciclo de reloj para mover bits de manera precisa dentro y fuera de la memoria y registros, y esto representa más del 90% del tiempo y energía en exceso.

Pero ahora, un estudio innovador propone una configuración personalizada de computación en memoria que podría reducir estas ineficiencias, potencialmente remodelando cómo desplegamos la IA generativa.

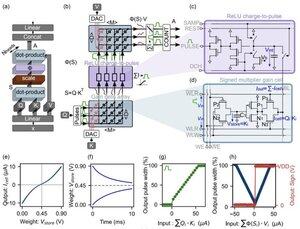

La innovación se centra en "celdas de ganancia"—memorias analógicas emergentes basadas en carga que funcionan tanto como almacenamiento como motores de computación.

A diferencia de las GPU digitales, que cargan laboriosamente proyecciones de tokens desde la caché a la SRAM para cada paso de generación, esta arquitectura mantiene los datos donde ocurre el cálculo: ¡justo EN EL CHIP! Con una velocidad de reloj cercana a LA VELOCIDAD DE LA LUZ porque nunca está encendido/apagado como en el binario digital.

Al aprovechar operaciones de producto punto analógicas en paralelo, el diseño calcula la autoatención de manera nativa, evitando el movimiento de datos que afecta al hardware de GPU.

Para cerrar la brecha entre los modelos digitales ideales y las ruidosas realidades de los circuitos analógicos, los investigadores idearon un ingenioso algoritmo de inicialización.

Este método adapta LLMs preentrenados, como GPT-2, sin necesidad de un reentrenamiento completo, asegurando una paridad de rendimiento sin problemas a pesar de no idealidades como desviaciones de voltaje o límites de precisión.

¡Los resultados son nada menos que asombrosos!

...

Parte superior

Clasificación

Favoritos