Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BOOM! GROTE AI SNELHEIDVERHOOGING!

Hot Rod AI 100 keer snellere inferentie 100.000 keer minder energie!

—

Herleving van Analoge Circuits: Een Sprong Naar Ultra-Efficiënte AI met In-Memory Aandacht

Ik begon met analoge elektronica toen ik een kind was en dacht altijd dat analoge computers een comeback zouden maken. Analoge computing van de neurale netwerken uit de jaren '60 gebruikte spanningsgebaseerde circuits in plaats van binaire klokken.

Analoge is Sneller Dan Digitaal

Grote taalmodellen zijn in wezen gebaseerd op de transformerarchitectuur, waarbij zelf-aandachtsmechanismen door enorme datasequenties filteren om het volgende woord of token te voorspellen.

Op conventionele GPU's verbruikt het verplaatsen van gegevens tussen geheugen caches en verwerkingsunits veel tijd en energie, wat de hele systeem vertraagt. Ze vereisen een klokcyclus om bits precies in en uit geheugen en registers te verplaatsen, en dit is >90% van de tijd en energie overhead.

Maar nu stelt een baanbrekende studie een aangepaste in-memory computing setup voor die deze inefficiënties kan verminderen, wat mogelijk de manier waarop we generatieve AI inzetten kan hervormen.

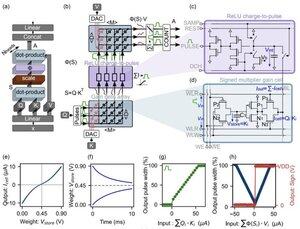

De innovatie richt zich op "gain cells"—opkomende spanningsgebaseerde analoge geheugens die zowel als opslag- als rekeneenheden fungeren.

In tegenstelling tot digitale GPU's, die moeizaam tokenprojecties van de cache naar SRAM laden voor elke generatie stap, houdt deze architectuur gegevens waar de berekeningen plaatsvinden: RECHT OP DE CHIP! Met een kloksnelheid dicht bij DE SNELHEID VAN LICHT omdat het nooit aan/uit is zoals in digitale binaire systemen.

Door gebruik te maken van parallelle analoge dot-product operaties, berekent het ontwerp zelf-aandacht op een natuurlijke manier, waardoor de databeweging die GPU-hardware teistert, wordt omzeild.

Om de kloof te overbruggen tussen ideale digitale modellen en de ruisige realiteit van analoge circuits, hebben de onderzoekers een slimme initialisatie-algoritme bedacht.

Deze methode past voorgetrainde LLM's, zoals GPT-2, aan zonder de noodzaak voor volledige hertraining, wat zorgt voor naadloze prestatiepariteit ondanks niet-ideale omstandigheden zoals spanningsafwijkingen of precisiegrenzen.

De resultaten zijn niets minder dan verbluffend!

...

Boven

Positie

Favorieten