トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ブーム!AI大幅高速化!

Hot Rod AI 推論速度 100,000 倍の電力削減!

—

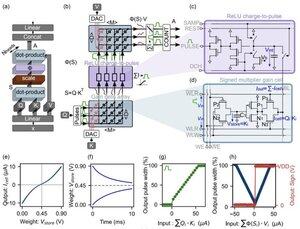

アナログ回路の復活: インメモリアテンションによる超効率的な AI への飛躍

私は子供の頃からアナログ電子機器に携わり始め、アナログコンピュータが復活するだろうとずっと思っていました。1960年代のニューラルネットワークのアナログコンピューティングは、バイナリクロックではなく電圧ベースの回路を使用していました。

アナログはデジタルよりも速い

大規模言語モデルの中核となるのはトランスフォーマー アーキテクチャであり、セルフアテンション メカニズムが膨大な一連のデータをふるいにかけ、次の単語やトークンを予測します。

従来のGPUでは、メモリキャッシュと処理ユニットの間でデータを往復させると、時間とエネルギーが消費され、システム全体がボトルネックになります。メモリやレジスタにビットを正確に出し入れするにはクロックサイクルが必要であり、これは時間とエネルギーのオーバーヘッドの>90%です。

しかし今回、画期的な研究により、これらの非効率性を削減し、生成 AI の導入方法を再構築できるカスタムのインメモリ コンピューティング セットアップが提案されています。

このイノベーションは、ストレージエンジンと計算エンジンの両方を兼ねる新しい電荷ベースのアナログメモリである「ゲインセル」を中心としています。

生成ステップごとにキャッシュからSRAMにトークンプロジェクションを手間をかけてロードするデジタルGPUとは異なり、このアーキテクチャは、計算が行われる場所、つまりチップ上にデータを保持します。デジタルバイナリのようにオン/オフが決してないため、クロック速度は THE SPEED OF LIGHT に近いです。

並列アナログ内積演算を活用することで、この設計はセルフアテンションをネイティブに計算し、GPU ハードウェアを悩ませるデータ移動を回避します。

理想的なデジタル モデルとアナログ回路のノイズの多い現実の間のギャップを埋めるために、研究者らは巧妙な初期化アルゴリズムを考案しました。

この方法は、GPT-2などの事前トレーニングされたLLMを完全な再トレーニングを必要とせずに適応させ、電圧ドリフトや精度制限などの非理想的にもかかわらず、シームレスなパフォーマンスパリティを保証します。

結果は驚くべきものでした。

...

トップ

ランキング

お気に入り