Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BUM! GRANDE ACELERAÇÃO DE IA!

Hot Rod AI Inferência 100 vezes mais rápida 100.000 vezes menos potência!

—

Revivendo circuitos analógicos: um salto em direção à IA ultraeficiente com atenção na memória

Comecei na eletrônica analógica quando era criança e sempre pensei que os computadores analógicos voltariam. A computação analógica das redes neurais da década de 1960 usava circuitos baseados em voltagem em vez de relógios binários.

O analógico é mais rápido que o digital

Grandes modelos de linguagem em seu núcleo está a arquitetura do transformador, onde os mecanismos de autoatenção filtram vastas sequências de dados para prever a próxima palavra ou token.

Em GPUs convencionais, o transporte de dados entre caches de memória e unidades de processamento consome tempo e energia, causando gargalos em todo o sistema. Eles exigem um ciclo de clock para mover com precisão os bits para dentro e para fora da memória e dos registradores, e isso é >90% da sobrecarga de tempo e energia.

Mas agora um estudo inovador propõe uma configuração de computação em memória personalizada que pode reduzir essas ineficiências, potencialmente remodelando a forma como implantamos a IA generativa.

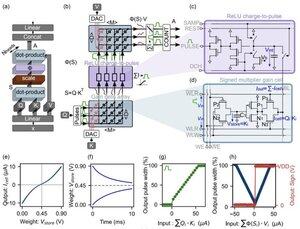

A inovação se concentra em "células de ganho" - memórias analógicas emergentes baseadas em carga que funcionam como mecanismos de armazenamento e computação.

Ao contrário das GPUs digitais, que carregam laboriosamente projeções de tokens do cache para a SRAM para cada etapa de geração, essa arquitetura mantém os dados onde a matemática acontece: BEM NO CHIP! Com uma velocidade de clock próxima à A VELOCIDADE DA LUZ porque nunca está ligado / desligado como no binário digital.

Ao alavancar operações paralelas de produtos pontuais analógicos, o design calcula a autoatenção nativamente, evitando a movimentação de dados que assola o hardware da GPU.

Para preencher a lacuna entre os modelos digitais ideais e as realidades ruidosas dos circuitos analógicos, os pesquisadores desenvolveram um algoritmo de inicialização inteligente.

Este método adapta LLMs pré-treinados, como GPT-2, sem a necessidade de retreinamento completo, garantindo paridade de desempenho perfeita, apesar de não idealidades, como desvios de tensão ou limites de precisão.

Os resultados são nada menos que impressionantes!

...

Melhores

Classificação

Favoritos