Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BOOM! AUMENTO MAIOR DE VELOCIDADE DA IA!

Hot Rod IA 100 vezes mais rápido na inferência e 100.000 vezes menos consumo de energia!

—

Revitalizando Circuitos Analógicos: Um Salto em Direção à IA Ultra-Eficiente com Atenção em Memória

Comecei na eletrônica analógica quando era criança e sempre pensei que os computadores analógicos fariam um retorno. A computação analógica das redes neurais dos anos 1960 usava circuitos baseados em tensão em vez de relógios binários.

Analógico é Mais Rápido que Digital

Nos grandes modelos de linguagem, no seu núcleo, está a arquitetura transformer, onde mecanismos de autoatenção filtram vastas sequências de dados para prever a próxima palavra ou token.

Em GPUs convencionais, o transporte de dados entre caches de memória e unidades de processamento consome tempo e energia, estrangulando todo o sistema. Eles requerem um ciclo de relógio para mover bits de forma precisa para dentro e fora da memória e dos registradores, e isso representa >90% do tempo e do consumo de energia.

Mas agora um estudo inovador propõe uma configuração personalizada de computação em memória que poderia reduzir essas ineficiências, potencialmente remodelando a forma como implantamos IA generativa.

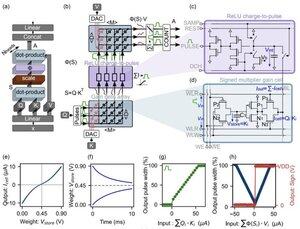

A inovação centra-se em "células de ganho"—memórias analógicas baseadas em carga emergentes que funcionam tanto como armazenamento quanto como motores de computação.

Ao contrário das GPUs digitais, que carregam laboriosamente projeções de tokens do cache para SRAM a cada passo de geração, esta arquitetura mantém os dados onde a matemática acontece: diretamente NO CHIP! Com uma velocidade de relógio próxima à VELOCIDADE DA LUZ porque nunca está ligado/desligado como no binário digital.

Ao aproveitar operações de produto escalar analógicas paralelas, o design calcula a autoatenção de forma nativa, evitando o movimento de dados que atormenta o hardware da GPU.

Para preencher a lacuna entre modelos digitais ideais e as realidades barulhentas dos circuitos analógicos, os pesquisadores elaboraram um algoritmo de inicialização inteligente.

Este método adapta LLMs pré-treinados, como o GPT-2, sem a necessidade de um retrabalho completo, garantindo paridade de desempenho contínua, apesar de não idealidades como desvios de tensão ou limites de precisão.

Os resultados são nada menos que impressionantes!

...

Top

Classificação

Favoritos