Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BOOM! ACCELERARE MAJORĂ AI!

Hot Rod AI: inferență de 100 de ori mai rapidă, de 100.000 de ori mai puțină putere!

—

Revigorarea circuitelor analogice: un salt către inteligența artificială ultra-eficientă cu atenție în memorie

Mi-am început cariera în electronica analogică când eram copil și întotdeauna am crezut că computerele analogice vor reveni. Calculul analogic al rețelelor neuronale din anii 1960 a folosit circuite bazate pe tensiune mai degrabă decât ceasuri binare.

Analogul este mai rapid decât cel digital

Modelele lingvistice mari se află arhitectura transformatorului, în care mecanismele de auto-atenție trec prin secvențe vaste de date pentru a prezice următorul cuvânt sau token.

Pe GPU-urile convenționale, naveta datelor între cache-urile de memorie și unitățile de procesare consumă timp și energie, blocând întregul sistem. Acestea necesită un ciclu de ceas pentru a muta cu precizie biții în memorie și registre, iar acest lucru reprezintă >90% din timpul și energia generală.

Dar acum un studiu revoluționar propune o configurație personalizată de calcul în memorie care ar putea reduce aceste ineficiențe, remodelând modul în care implementăm AI generativă.

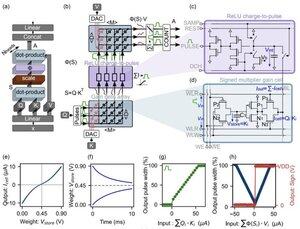

Inovația se concentrează pe "celule de câștig" – memorii analogice emergente bazate pe sarcină care se dublează atât ca motoare de stocare, cât și ca motoare de calcul.

Spre deosebire de GPU-urile digitale, care încarcă cu greu proiecții de token din cache în SRAM pentru fiecare etapă de generare, această arhitectură păstrează datele acolo unde se întâmplă matematica: chiar PE CIP! Cu o viteză de ceas apropiată de VITEZA LUMINII, deoarece nu este niciodată pornit/oprit ca în binarul digital.

Prin utilizarea operațiunilor analogice paralele, designul calculează atenția de sine în mod nativ, ocolind mișcarea datelor care afectează hardware-ul GPU.

Pentru a reduce decalajul dintre modelele digitale ideale și realitățile zgomotoase ale circuitelor analogice, cercetătorii au conceput un algoritm inteligent de inițializare.

Această metodă adaptează LLM-urile pre-antrenate, cum ar fi GPT-2, fără a fi nevoie de reinstruire completă, asigurând paritatea perfectă a performanței în ciuda non-idealităților, cum ar fi deviațiile de tensiune sau limitele de precizie.

Rezultatele sunt uluitoare!

...

Limită superioară

Clasament

Favorite