Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

BOOM! GROßE AI-GESCHWINDIGKEITSSTEIGERUNG!

Hot Rod AI 100 Mal schnellere Inferenz, 100.000 Mal weniger Energie!

—

Wiederbelebung analoger Schaltungen: Ein Sprung in Richtung ultra-effizienter KI mit In-Memory-Attention

Ich habe als Kind mit analoger Elektronik angefangen und dachte immer, dass analoge Computer ein Comeback feiern würden. Die analoge Berechnung der 1960er Jahre verwendete spannungsbasierte Schaltungen anstelle von binären Takten.

Analog ist schneller als digital

Im Kern großer Sprachmodelle liegt die Transformatorarchitektur, bei der Selbstaufmerksamkeitsmechanismen durch riesige Datenmengen filtern, um das nächste Wort oder Token vorherzusagen.

Auf herkömmlichen GPUs frisst das Verschieben von Daten zwischen Speichercaches und Verarbeitungseinheiten Zeit und Energie und verstopft das gesamte System. Sie benötigen einen Taktzyklus, um Bits präzise in den Speicher und die Register zu bewegen, und das ist >90% des Zeit- und Energieaufwands.

Aber jetzt schlägt eine bahnbrechende Studie ein maßgeschneidertes In-Memory-Computing-Setup vor, das diese Ineffizienzen drastisch reduzieren könnte und potenziell die Art und Weise, wie wir generative KI einsetzen, umgestalten könnte.

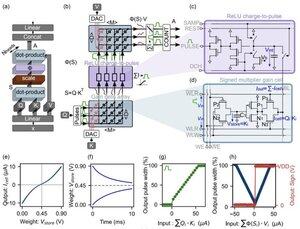

Die Innovation konzentriert sich auf "Gain Cells" – aufkommende spannungsbasierte analoge Speicher, die sowohl als Speicher- als auch als Rechenmaschinen fungieren.

Im Gegensatz zu digitalen GPUs, die mühsam Token-Projektionen von Cache in SRAM für jeden Generationsschritt laden, hält diese Architektur die Daten dort, wo die Berechnung stattfindet: direkt AUF DEM CHIP! Mit einer Taktgeschwindigkeit nahe der GESCHWINDIGKEIT DES LICHTS, weil sie nie ein/aus ist wie im digitalen Binärsystem.

Durch die Nutzung paralleler analoger Punktproduktoperationen berechnet das Design die Selbstaufmerksamkeit nativ und umgeht die Datenbewegung, die die GPU-Hardware plagt.

Um die Lücke zwischen idealen digitalen Modellen und den rauschenden Realitäten analoger Schaltungen zu überbrücken, entwickelten die Forscher einen cleveren Initialisierungsalgorithmus.

Diese Methode passt vortrainierte LLMs, wie GPT-2, an, ohne dass eine vollständige Neutrainierung erforderlich ist, und gewährleistet eine nahtlose Leistungsparität trotz Nicht-Idealitäten wie Spannungsdriften oder Präzisionsgrenzen.

Die Ergebnisse sind nichts weniger als überwältigend!

...

Top

Ranking

Favoriten