熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

轟!重大的AI加速!

Hot Rod AI 推理速度提高100倍,功耗降低100,000倍!

——

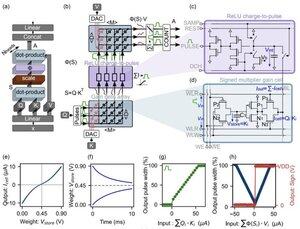

復興模擬電路:朝著超高效AI的內存注意力躍進

我小時候開始接觸模擬電子學,一直認為模擬計算機會捲土重來。1960年代的神經網絡使用基於電壓的電路,而不是二進制時鐘。

模擬比數字更快

大型語言模型的核心是變換器架構,其中自注意力機制在大量數據序列中篩選,以預測下一個單詞或標記。

在傳統的GPU上,數據在內存緩存和處理單元之間的傳輸消耗了大量時間和能量,成為整個系統的瓶頸。它們需要一個時鐘週期來精確地將比特移入和移出內存和寄存器,這佔用了90%以上的時間和能量開銷。

但現在一項突破性的研究提出了一種定製的內存計算設置,可以削減這些低效,可能重塑我們部署生成AI的方式。

這一創新集中在“增益單元”上——新興的基於電荷的模擬存儲器,既充當存儲又充當計算引擎。

與數字GPU不同,後者在每個生成步驟中費力地將標記投影從緩存加載到SRAM,這種架構將數據保留在數學運算發生的地方:就在芯片上!由於它從未像數字二進制那樣開/關,因此時鐘速度接近光速。

通過利用並行的模擬點積操作,該設計本地計算自注意力,避免了困擾GPU硬件的數據移動。

為了彌合理想數字模型與模擬電路噪聲現實之間的差距,研究人員設計了一種巧妙的初始化算法。

該方法在不需要完全重新訓練的情況下,適應預訓練的LLM,如GPT-2,確保儘管存在電壓漂移或精度限制等非理想因素,仍能實現無縫的性能平衡。

結果令人震驚!

...

熱門

排行

收藏