Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eric Vishria

Fastlege @Benchmark. Regissør: @ConfluentInc @CerebrasSystems @Contentful @Benchling @CommerceLayer @acuitymd @FireworksAI_HQ @quilterai @pomerium_io @DeepCogito

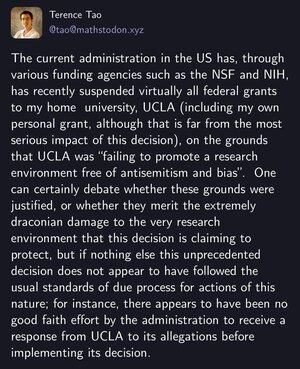

Eric Vishria lagt ut på nytt

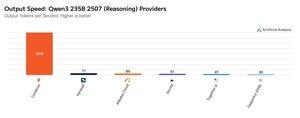

Cerebras har demonstrert sin evne til å være vert for store MoEs med svært høye hastigheter denne uken, og lanserte Qwen3 235B 2507 og Qwen3 Coder 480B-endepunkter ved >1,500 utgangstokens/s

➤ @CerebrasSystems tilbyr nå endepunkter for både Qwen3 235B 2507 Resonnement og Ikke-resonnement. Begge modellene har 235B totale parametere med 22B aktive.

➤ Qwen 3 235B 2507 Reasoning tilbyr intelligens som kan sammenlignes med o4-mini (høy) og DeepSeek R1 0528. Den ikke-resonnerende varianten tilbyr intelligens som kan sammenlignes med Kimi K2 og godt over GPT-4.1 og Llama 4 Maverick.

➤ Qwen3 Coder 480B har 480B totale parametere med 35B aktive. Denne modellen er spesielt sterk for agentkoding og kan brukes i en rekke kodeagentverktøy, inkludert Qwen3-Coder CLI.

Cerebras' lanseringer representerer første gang dette intelligensnivået har vært tilgjengelig med disse utgangshastighetene og har potensial til å låse opp nye brukstilfeller - som å bruke en resonnementmodell for hvert trinn i en agent uten å måtte vente i minutter.

25,02K

SOTA, vestlige åpne modeller ✅

Veldig store modeller ✅

Ny dimensjon for å skalere opp intelligens✅

Bygget for under 3,5 millioner 🤯 dollar

Vært fantastisk å jobbe med teamet siden @benchmark investering i november i fjor. Spesiell takk til @adityaag @southpkcommons for at du introduserte oss!

Drishan Arora1. aug., 01:02

I dag lanserer vi 4 hybride resonneringsmodeller i størrelsene 70B, 109B MoE, 405B, 671B MoE under åpen lisens.

Dette er noen av de sterkeste LLM-ene i verden, og fungerer som et bevis på konseptet for et nytt AI-paradigme - iterativ selvforbedring (AI-systemer som forbedrer seg selv).

Den største 671B MoE-modellen er blant de sterkeste åpne modellene i verden. Den matcher/overgår ytelsen til de nyeste DeepSeek v3- og DeepSeek R1-modellene begge, og nærmer seg lukkede frontmodeller som o3 og Claude 4 Opus.

9,57K

.@lqiao, administrerende direktør i Fireworks, sa til meg "det har vært spesielt vanskelig å finne ledere som har den rette balansen mellom mønstermatching og stifinning."

Jeg syntes det var en utmerket artikulasjon av vanskeligheten med å lede AI-innfødte.

Og relatert til @rabois innlegg om å finne ut den nye organisasjonen i møte med AI.

Eric Vishria31. mai 2025

I det store og hele sliter SaaS-ledere som faller inn i raskt skalerende AI-native co-er. Det er som å slippe landlige tyskere inn i midten av det moderne Tokyo.

AI-sjefene kjenner bare dette tempoet, teknologien, salgssyklusen. og kan ikke forklare hvordan disse lederne bør omformulere. SaaS-folkene snakker om kvotekapasitet, qtrly-veikart og bedrifter, som ikke betyr noe for AI-sjefene og generelt er irrelevante, i hvert fall foreløpig.

Å bygge bro over dette er vanskelig, men kritisk. Den produktive kombinasjonen av denne bølge- og skaleringsekspertisen vil turbolade disse allerede rippende selskapene.

9,33K

Topp

Rangering

Favoritter

Trendende onchain

Trendende på X

Nylig toppfinansiering

Mest lagt merke til