Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Eric Vishria

Лікар загальної практики @Benchmark. Режисер: @ConfluentInc @CerebrasSystems @Contentful @Benchling @CommerceLayer @acuitymd @FireworksAI_HQ @quilterai @pomerium_io @DeepCogito

Користувач Eric Vishria поділився

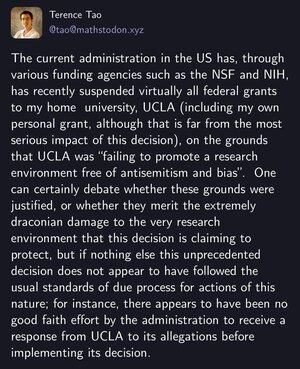

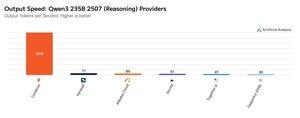

Цього тижня Cerebras продемонструвала свою здатність розміщувати великі MoEs на дуже високих швидкостях, запустивши кінцеві точки Qwen3 235B 2507 та Qwen3 Coder 480B зі швидкістю >1 500 вихідних токенів/с

➤ @CerebrasSystems тепер пропонує кінцеві точки для міркувань і неміркувань Qwen3 235B 2507. Обидві моделі мають загальні параметри 235В при 22В активних.

➤ Qwen 3 235B 2507 Reasoning пропонує інтелект, який можна порівняти з o4-mini (високий) і DeepSeek R1 0528. Варіант Non-reasoning пропонує інтелект, який можна порівняти з Kimi K2 і значно перевищує GPT-4.1 і Llama 4 Maverick.

➤ Qwen3 Coder 480B має загальні параметри 480B при 35B активних. Ця модель особливо потужна для агентного кодування і може використовуватися в різних інструментах кодувальних агентів, включаючи Qwen3-Coder CLI.

Запуск Cerebras є першим випадком, коли цей рівень інтелекту був доступний на таких вихідних швидкостях і має потенціал для відкриття нових варіантів використання - наприклад, використання моделі міркування для кожного кроку агента без необхідності чекати кілька хвилин.

25,02K

СОТА, західні відкриті моделі ✅

Дуже великі моделі ✅

Новий вимір для масштабування інтелекту✅

Створено менш ніж за 3,5 мільйона 🤯 доларів США

Було чудово працювати з командою з моменту інвестицій @benchmark у листопаді минулого року. Особлива подяка @adityaag @southpkcommons за те, що познайомили з нами!

Drishan Arora1 серп., 01:02

Сьогодні ми випускаємо 4 гібридні моделі розмірів 70B, 109B MoE, 405B, 671B MoE за відкритою ліцензією.

Це одні з найсильніших LLM у світі, і вони служать доказом концепції нової парадигми штучного інтелекту - ітеративного самовдосконалення (системи штучного інтелекту вдосконалюють самі себе).

Найбільша модель 671B MoE є однією з найміцніших відкритих моделей у світі. Він відповідає/перевершує продуктивність останніх моделей DeepSeek v3 і DeepSeek R1 і наближається до моделей із закритими кордонами, таких як o3 і Claude 4 Opus.

9,58K

.@lqiao, генеральний директор Fireworks, сказав мені, що «знайти лідерів, які мають правильний баланс між зіставленням шаблонів і пошуком шляху, було особливо складно».

Я подумав, що це чудове формулювання складності лідерства серед носіїв штучного інтелекту.

І пов'язаний з публікацією @rabois про те, як з'ясувати нову організацію в умовах штучного інтелекту.

Eric Vishria31 трав. 2025 р.

За великим рахунком, лідери SaaS, які потрапляють у швидко масштабовані компанії, що працюють зі штучним інтелектом, зазнають труднощів. Це все одно, що висадити сільських німців у середину сучасного Токіо.

Керівники AI знають лише цей темп, технології, цикл продажів. і не може пояснити, як ці лідери мають переосмислити. Люди SaaS говорять про квотну потужність, дорожні карти qtrly та підприємство, які нічого не означають для керівників AI і загалом не мають значення, принаймні на даний момент.

Подолати це важко, але критично важливо. Продуктивне поєднання цієї хвилі та досвіду масштабування дало б поштовх цим компаніям, які і без того розриваються.

9,34K

Найкращі

Рейтинг

Вибране

Актуальне ончейн

Популярні в X

Нещодавнє найкраще фінансування

Найбільш варте уваги