热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

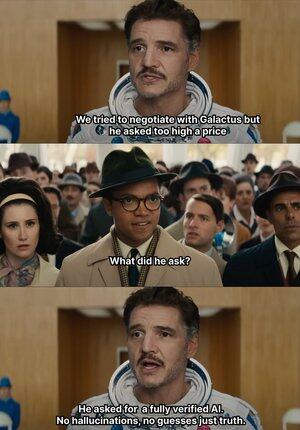

AI 开始瞎编的时候,@Mira_Network 直接抬手给一巴掌😂

讲个有意思的事情, 2023 年一位资深纽约律师将一份法律意见提交至联邦法院

资料看起来没啥破绽,但却被法官一眼看穿,文中所列的案例全都不存在,没想到都是 ChatGPT 编造

从2023年 openai 成为我们办公学习的主流生成工具

在这之前我平时查找资料要翻百度谷歌,现在只需要 gpt 给我总结

如此以往就养成了习惯,饭来张口衣来伸手,也懒得去验证真假直接采用

AI 即使乱编谁也不知道真假,就会诞生很多乌龙事件

因为只要语言顺滑、逻辑像样,它就能骗过绝大多数人

但其实这种事情不能全赖 AI,AI 的输出越来越多,但验证能力几乎停滞,幻觉问题成为结构性风险

也正是在这个背景下,@Mira_Network 的 AI 输出验证网络成为刚需

@Mira_Network 建立一个由多个模型组成的验证网络,用系统之间的交叉判断,来弥补单个模型无法自证的问题

▪️第一步是拆解陈述

任何一段复杂的输出,都会被分解为一系列更基础的主张

例如:地球围绕太阳转,月球围绕地球转会被拆成两条独立语句,每条都可以单独判断真假

接下来多个模型接入验证流程,每个模型独立给出判断,系统会统计它们之间的共识程度,并评估信任度

如果共识高于阈值,该主张被视为有效;如果分歧严重,则触发二次检查或驳回

▪️数据来自 Mira 的测试验证显示:

> 三模型共识机制将准确率从 73.1% 提升至 95.6%

> 整体错误率下降 84%

> 多模型之间的平均一致性 κ 值接近 0.8,已具备稳定判断能力

当然如果只是让多个模型投票判断真假,很容易出现随机猜测的行为

▪️Mira 之所以能运行,是因为它将博弈机制嵌入了系统结构

验证不是无代价行为。每个参与验证的模型节点,都需要承担结果责任

如果频繁与其他节点判断冲突,或者被检测出明显偏离逻辑轨迹,将失去验证权,并丧失网络中的经济激励

为了让验证真正落地,Mira 在执行架构上做了大量工程优化

▪️最关键的一项是:将验证输出压缩成单一 token

这种 claim transformation 技术极大降低了每次验证的成本,使得系统能在大规模应用场景中运行,而不会拖垮吞吐

▪️隐私层面,Mira 的验证节点从不接触完整文本

系统自动将内容拆分,分布给不同节点,保证数据在验证过程中的不可还原性

过去这一年,AI 被推向越来越多的场景中,生成速度不断加快,但验证机制基本停滞

AI 胡说八道不会被问责但人会😭

所以 @MiraNetworkCN 的角色就是当 AI 瞎几把吹的时候能出手拦住

2.13K

热门

排行

收藏