Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

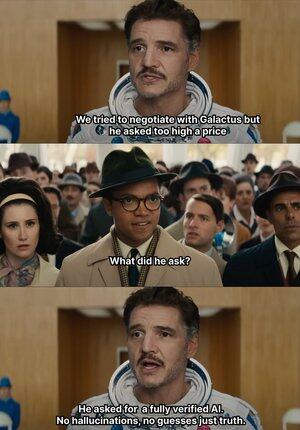

Quando l'AI inizia a inventare, @Mira_Network alza direttamente la mano e dà uno schiaffo 😂

Racconto una cosa interessante: nel 2023, un avvocato esperto di New York ha presentato un parere legale a un tribunale federale.

I documenti sembravano non avere difetti, ma sono stati subito smascherati dal giudice; tutti i casi citati nel testo non esistevano, si è scoperto che erano stati inventati da ChatGPT.

Dal 2023, OpenAI è diventato lo strumento di generazione principale per il nostro lavoro e studio.

Prima di questo, per cercare informazioni dovevo usare Baidu e Google, ora ho solo bisogno che GPT mi faccia un riassunto.

Così, nel tempo, ho sviluppato l'abitudine di ricevere tutto pronto, senza nemmeno preoccuparmi di verificare la verità, lo uso direttamente.

L'AI, anche se inventa a caso, nessuno sa se è vero o falso, e così nascono molti eventi imbarazzanti.

Perché basta che il linguaggio sia fluido e la logica sembri ragionevole, e può ingannare la stragrande maggioranza delle persone.

Ma in realtà, non si può dare tutta la colpa all'AI; l'output dell'AI sta aumentando, ma la capacità di verifica è quasi stagnante, il problema delle illusioni è diventato un rischio strutturale.

Ed è proprio in questo contesto che la rete di verifica dell'output AI di @Mira_Network è diventata una necessità.

@Mira_Network ha creato una rete di verifica composta da più modelli, utilizzando il giudizio incrociato tra i sistemi per compensare il problema dell'auto-verifica dei singoli modelli.

▪️Il primo passo è scomporre le affermazioni.

Qualsiasi output complesso verrà scomposto in una serie di affermazioni più basilari.

Ad esempio: "La Terra orbita attorno al Sole" e "La Luna orbita attorno alla Terra" verranno scomposte in due frasi indipendenti, ognuna delle quali può essere giudicata singolarmente.

Successivamente, più modelli si connettono al processo di verifica, ogni modello fornisce un giudizio indipendente, il sistema calcola il grado di consenso tra di essi e valuta il livello di fiducia.

Se il consenso supera una certa soglia, l'affermazione è considerata valida; se ci sono gravi divergenze, si attiva un secondo controllo o viene respinta.

▪️I dati provenienti dai test di verifica di Mira mostrano:

> Il meccanismo di consenso tra tre modelli ha aumentato l'accuratezza dal 73,1% al 95,6%.

> Il tasso di errore complessivo è diminuito dell'84%.

> La coerenza media κ tra i modelli è vicina a 0,8, dimostrando una capacità di giudizio stabile.

Naturalmente, se si tratta solo di far votare più modelli per giudicare la verità, è facile che si verifichino comportamenti di indovinare casualmente.

▪️Il motivo per cui Mira può funzionare è che ha incorporato meccanismi di gioco nella struttura del sistema.

La verifica non è un'azione senza costi. Ogni nodo modello che partecipa alla verifica deve assumersi la responsabilità dei risultati.

Se frequentemente giudica in conflitto con altri nodi, o viene rilevato un evidente allontanamento dalla logica, perderà il diritto di verifica e perderà gli incentivi economici nella rete.

Per rendere la verifica realmente operativa, Mira ha effettuato molte ottimizzazioni ingegneristiche nell'architettura di esecuzione.

▪️Una delle cose più importanti è: comprimere l'output di verifica in un singolo token.

Questa tecnologia di trasformazione delle affermazioni riduce notevolmente il costo di ogni verifica, consentendo al sistema di operare in scenari di applicazione su larga scala senza compromettere il throughput.

▪️A livello di privacy, i nodi di verifica di Mira non accedono mai al testo completo.

Il sistema scompone automaticamente il contenuto e lo distribuisce a nodi diversi, garantendo l'irreversibilità dei dati durante il processo di verifica.

Negli ultimi dodici mesi, l'AI è stata spinta in sempre più scenari, la velocità di generazione è aumentata, ma i meccanismi di verifica sono rimasti sostanzialmente fermi.

L'AI può dire qualsiasi cosa senza essere ritenuta responsabile, ma le persone sì 😭

Quindi il ruolo di @MiraNetworkCN è quello di intervenire quando l'AI inizia a blaterare.

2,16K

Principali

Ranking

Preferiti