熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

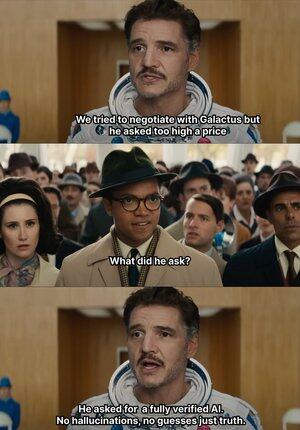

AI 開始瞎編的時候,@Mira_Network 直接擡手給一巴掌😂

講個有意思的事情, 2023 年一位資深紐約律師將一份法律意見提交至聯邦法院

資料看起來沒啥破綻,但卻被法官一眼看穿,文中所列的案例全都不存在,沒想到都是 ChatGPT 編造

從2023年 openai 成為我們辦公學習的主流生成工具

在這之前我平時查找資料要翻百度谷歌,現在只需要 gpt 給我總結

如此以往就養成了習慣,飯來張口衣來伸手,也懶得去驗證真假直接採用

AI 即使亂編誰也不知道真假,就會誕生很多烏龍事件

因為只要語言順滑、邏輯像樣,它就能騙過絕大多數人

但其實這種事情不能全賴 AI,AI 的輸出越來越多,但驗證能力幾乎停滯,幻覺問題成為結構性風險

也正是在這個背景下,@Mira_Network 的 AI 輸出驗證網絡成為剛需

@Mira_Network 建立一個由多個模型組成的驗證網絡,用系統之間的交叉判斷,來彌補單個模型無法自證的問題

▪️第一步是拆解陳述

任何一段複雜的輸出,都會被分解為一系列更基礎的主張

例如:地球圍繞太陽轉,月球圍繞地球轉會被拆成兩條獨立語句,每條都可以單獨判斷真假

接下來多個模型接入驗證流程,每個模型獨立給出判斷,系統會統計它們之間的共識程度,並評估信任度

如果共識高於閾值,該主張被視為有效;如果分歧嚴重,則觸發二次檢查或駁回

▪️數據來自 Mira 的測試驗證顯示:

> 三模型共識機制將準確率從 73.1% 提升至 95.6%

> 整體錯誤率下降 84%

> 多模型之間的平均一致性 κ 值接近 0.8,已具備穩定判斷能力

當然如果只是讓多個模型投票判斷真假,很容易出現隨機猜測的行為

▪️Mira 之所以能運行,是因為它將博弈機制嵌入了系統結構

驗證不是無代價行為。每個參與驗證的模型節點,都需要承擔結果責任

如果頻繁與其他節點判斷衝突,或者被檢測出明顯偏離邏輯軌跡,將失去驗證權,並喪失網絡中的經濟激勵

為了讓驗證真正落地,Mira 在執行架構上做了大量工程優化

▪️最關鍵的一項是:將驗證輸出壓縮成單一 token

這種 claim transformation 技術極大降低了每次驗證的成本,使得系統能在大規模應用場景中運行,而不會拖垮吞吐

▪️隱私層面,Mira 的驗證節點從不接觸完整文本

系統自動將內容拆分,分佈給不同節點,保證數據在驗證過程中的不可還原性

過去這一年,AI 被推向越來越多的場景中,生成速度不斷加快,但驗證機制基本停滯

AI 胡說八道不會被問責但人會😭

所以 @MiraNetworkCN 的角色就是當 AI 瞎幾把吹的時候能出手攔住

2.16K

熱門

排行

收藏