Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

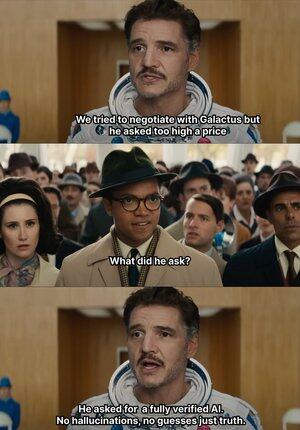

Når AI-en begynner å gjøre opp i blinde, løfter @Mira_Network hånden direkte og slår 😂 den

På et interessant notat, i 2023 sendte en senior New York-advokat inn en juridisk uttalelse til den føderale domstolen

Dataene ser ikke ut til å ha noen feil, men dommeren gjennomskuet dem med et øyeblikk, og ingen av sakene som er oppført i artikkelen eksisterte, men jeg forventet ikke at de skulle være fabrikkert av ChatGPT

Fra 2023 har OpenAI blitt det vanlige generative verktøyet for kontorlæringen vår

Før dette måtte jeg vanligvis slå opp Baidu og Google for å finne informasjon, men nå trenger jeg bare GPT for å oppsummere det

På denne måten har jeg utviklet en vane med å strekke meg etter mat, og jeg er for lat til å verifisere ektheten og direkte adopsjon av den

Selv om AI ikke finner på at ingen vet om det er sant eller usant, vil mange oolong-hendelser bli født

For så lenge språket er jevnt og logisk, kan det lure de aller fleste mennesker

Men faktisk kan ikke denne typen ting stole helt på AI, AI sender ut mer og mer, men verifiseringsevnen er nesten stillestående, og hallusinasjonsproblemet har blitt en strukturell risiko

Det er i denne sammenhengen at @Mira_Network AI-utgangsverifiseringsnettverk har blitt et rigid behov

@Mira_Network Etablere et verifiseringsnettverk sammensatt av flere modeller, og bruke kryssvurdering mellom systemer for å kompensere for problemet som en enkelt modell ikke kan selvsertifisere

▪️ Det første trinnet er å bryte ned utsagnet

Enhver kompleks produksjon er brutt ned i en rekke mer grunnleggende påstander

For eksempel kretser jorden rundt solen og månen kretser rundt jorden i to uavhengige utsagn, som hver for seg kan bedømmes som sanne eller usante

Deretter kobles flere modeller til verifiseringsprosessen, og hver modell gir vurderinger uavhengig, og systemet vil telle graden av konsensus mellom dem og evaluere graden av tillit

Hvis konsensus er over terskelen, anses påstanden som gyldig; Hvis uenigheten er alvorlig, utløses en ny sjekk eller oppsigelse

▪️ Dataene fra Miras testvalidering viser:

> Konsensusmekanisme med tre modeller forbedrer nøyaktigheten fra 73,1 % til 95,6 %

> 84 % reduksjon i samlet feilrate

> Den gjennomsnittlige konsistensen κ-verdien mellom flere modeller er nær 0,8, noe som har stabil vurderingsevne

Selvfølgelig, hvis du bare lar flere modeller stemme for å bedømme sannheten, er det lett å gjette tilfeldig

▪️Mira fungerer fordi det bygger inn spillmekanikken i systemstrukturen

Validering er ikke en kostnadsfri handling. Hver modellnode som deltar i valideringen må bære ansvaret for resultatene

Hvis den ofte er i konflikt med andre noders vurderinger eller oppdages å avvike betydelig fra den logiske banen, vil den miste sine valideringsrettigheter og miste økonomiske insentiver i nettverket

For å gjøre verifiseringen virkelig implementert, har Mira gjort mange tekniske optimaliseringer av utførelsesarkitekturen

▪️ Den mest kritiske er å komprimere valideringsutdataene til et enkelt token

Denne kravtransformasjonsteknologien reduserer kostnadene per verifisering dramatisk, slik at systemet kan operere i store brukstilfeller uten å bremse gjennomstrømningen

▪️ På personvernnivå berører Miras validatorer aldri hele teksten

Systemet deler automatisk innholdet og distribuerer det til forskjellige noder for å sikre irreduserbarheten til data under verifiseringsprosessen

Det siste året har AI blitt presset inn i flere og flere scenarier, og generasjonshastigheten har akselerert, men verifiseringsmekanismen har i utgangspunktet stagnert

AI vil ikke bli holdt ansvarlig, men folk vil 😭

Så @MiraNetworkCN rolle er å stoppe AI-en når den blåser noen blinde slag

2,16K

Topp

Rangering

Favoritter