トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

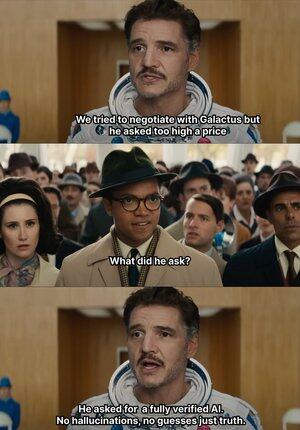

AIが無頓着にメイクを始めると、@Mira_Network直接手を上げて頬を打つ 😂

興味深いことに、2023 年にニューヨークの上級弁護士が連邦裁判所に法的意見書を提出しました

データには欠陥はないように見えますが、裁判官はそれを一目で見破り、記事に記載されているケースはどれも存在しませんでしたが、ChatGPT によって捏造されたとは予想していませんでした

2023 年から、OpenAI はオフィス学習の主流の生成ツールになりました

これ以前は、情報を見つけるために Baidu と Google を調べる必要がありましたが、今では GPT だけで要約できます

このようにして、私は食べ物に手を伸ばす習慣を身につけ、それが本物であるかどうか、そして直接採用するのが面倒です

AIがでっち上げても、それが真偽か誰にもわからない、多くのウーロン事件が生まれるだろう

なぜなら、言語が滑らかで論理的である限り、大多数の人々を欺くことができるからです

しかし実際には、この種のことはAIに完全に依存することはできず、AIはますます出力しますが、検証能力はほぼ停滞しており、幻覚の問題は構造的なリスクになっています

このような状況において、@Mira_Networkの AI 出力検証ネットワークが厳格なニーズとなっています

@Mira_Network 複数のモデルで構成される検証ネットワークを構築し、システム間のクロス判定を利用して、単一のモデルでは自己認証できない問題を補う

▪️ 最初のステップは、ステートメントを分解することです

複雑な出力は、より基本的な一連の主張に分解されます

たとえば、地球は太陽の周りを公転し、月は地球の周りを公転し、それぞれが真か偽かを別々に判断できます

次に、複数のモデルが検証プロセスに接続され、各モデルが独立して判断を下し、システムはそれらの間のコンセンサスの程度をカウントし、信頼度を評価します

コンセンサスがしきい値を超えている場合、その主張は有効であると見なされます。 意見の相違が深刻な場合は、2回目のチェックまたは解雇がトリガーされます

▪️ Mira のテスト検証のデータによると、次のことがわかります。

> 3モデルコンセンサスメカニズムにより、精度が73.1%から95.6%に向上

> 全体のエラー率を84%削減

> 複数のモデル間の平均一貫性κ値は0.8に近く、安定した判断能力を持っています

もちろん、ただ複数のモデルに投票して真実を判断させると、ランダムに推測しやすい

▪️Mira は、ゲームの仕組みをシステム構造に組み込んでいるため機能します

検証は無料の行為ではありません。 検証に参加する各モデルノードは、結果に対して責任を負う必要があります

他のノードの判断と頻繁に矛盾したり、論理的な軌道から大きく逸脱していることが検出されたりすると、検証権が失われ、ネットワーク内の経済的インセンティブが失われます

検証を実際に実装するために、Mira は実行アーキテクチャに多くのエンジニアリング最適化を行いました

▪️ 最も重要なのは、検証出力を単一のトークンに圧縮することです

このクレーム変換テクノロジーにより、検証あたりのコストが大幅に削減され、スループットを低下させることなく大規模なユースケースでシステムを運用できるようになります

▪️ プライバシーレベルでは、Mira のバリデーターは全文に触れることはありません

システムはコンテンツを自動的に分割して異なるノードに配布し、検証プロセス中のデータの還元不可能性を確保します

過去 1 年間で、AI はますます多くのシナリオに押し込まれ、生成速度は加速していますが、検証メカニズムは基本的に停滞しています

AIは責任を問われないが、人間は責任を問われる 😭

だから@MiraNetworkCNの役割はAIが盲目的な一撃を何度も飛ばすと阻止することだ

2.16K

トップ

ランキング

お気に入り