Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

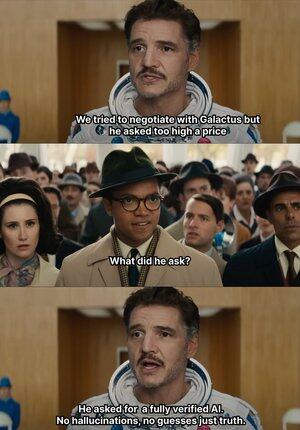

Ketika AI mulai berbaikan secara membabi buta, @Mira_Network langsung mengangkat tangannya dan menamparnya 😂

Pada catatan yang menarik, pada tahun 2023, seorang pengacara senior New York mengajukan pendapat hukum ke pengadilan federal

Data tampaknya tidak memiliki kekurangan, tetapi hakim melihatnya secara sekilas, dan tidak ada kasus yang tercantum dalam artikel yang ada, tetapi saya tidak berharap mereka dibuat-buat oleh ChatGPT

Mulai tahun 2023, OpenAI telah menjadi alat generatif utama untuk pembelajaran kantor kami

Sebelum ini, saya biasanya harus mencari Baidu dan Google untuk mencari informasi, tetapi sekarang saya hanya membutuhkan GPT untuk meringkasnya

Dengan cara ini, saya telah mengembangkan kebiasaan meraih makanan, dan saya terlalu malas untuk memverifikasi keaslian dan adopsi langsung

Bahkan jika AI mengarang tidak ada yang tahu apakah itu benar atau salah, banyak insiden oolong akan lahir

Karena selama bahasanya halus dan logis, itu dapat menipu sebagian besar orang

Namun pada kenyataannya, hal semacam ini tidak dapat sepenuhnya mengandalkan AI, output AI semakin banyak, tetapi kemampuan verifikasinya hampir stagnan, dan masalah halusinasi telah menjadi risiko struktural

Dalam konteks inilah jaringan verifikasi output AI @Mira_Network telah menjadi kebutuhan yang kaku

@Mira_Network Membangun jaringan verifikasi yang terdiri dari beberapa model, dan menggunakan penilaian silang antar sistem untuk menebus masalah yang tidak dapat disertifikasi sendiri oleh satu model

▪️ Langkah pertama adalah memecah pernyataan

Setiap output kompleks dipecah menjadi serangkaian klaim yang lebih mendasar

Misalnya, bumi berputar mengelilingi matahari dan bulan berputar mengelilingi bumi menjadi dua pernyataan independen, yang masing-masing dapat dinilai secara terpisah sebagai benar atau salah

Selanjutnya, beberapa model terhubung ke proses verifikasi, dan setiap model memberikan penilaian secara independen, dan sistem akan menghitung tingkat konsensus di antara mereka dan mengevaluasi tingkat kepercayaan

Jika konsensus di atas ambang batas, klaim dianggap sah; Jika perselisihan serius, pemeriksaan atau pemecatan kedua dipicu

▪️ Data dari validasi pengujian Mira menunjukkan:

> Mekanisme konsensus tiga model meningkatkan akurasi dari 73,1% menjadi 95,6%

> pengurangan 84% dalam tingkat kesalahan keseluruhan

> Nilai κ konsistensi rata-rata antara beberapa model mendekati 0,8, yang memiliki kemampuan penilaian yang stabil

Tentu saja, jika Anda membiarkan beberapa model memilih untuk menilai kebenaran, mudah untuk menebak secara acak

▪️Mira bekerja karena menyematkan mekanisme permainan ke dalam struktur sistem

Validasi bukanlah tindakan tanpa biaya. Setiap simpul model yang berpartisipasi dalam validasi harus memikul tanggung jawab atas hasilnya

Jika sering bertentangan dengan penilaian node lain atau terdeteksi menyimpang secara signifikan dari lintasan logis, ia akan kehilangan hak validasinya dan kehilangan insentif ekonomi dalam jaringan

Untuk membuat verifikasi benar-benar diterapkan, Mira telah melakukan banyak pengoptimalan teknik pada arsitektur eksekusi

▪️ Yang paling penting adalah mengompres output validasi menjadi satu token

Teknologi transformasi klaim ini secara dramatis mengurangi biaya per verifikasi, memungkinkan sistem beroperasi dalam kasus penggunaan skala besar tanpa memperlambat throughput

▪️ Pada tingkat privasi, validator Mira tidak pernah menyentuh teks lengkap

Sistem secara otomatis membagi konten dan mendistribusikannya ke node yang berbeda untuk memastikan data yang tidak dapat direduksi selama proses verifikasi

Dalam setahun terakhir, AI telah didorong ke lebih banyak skenario, dan kecepatan pembuatan telah dipercepat, tetapi mekanisme verifikasi pada dasarnya mandek

AI tidak akan dimintai pertanggungjawaban, tetapi orang-orang akan 😭

Jadi peran @MiraNetworkCN adalah menghentikan AI ketika meniup beberapa pukulan buta

2,16K

Teratas

Peringkat

Favorit