Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Иногда AI говорит неправильно не потому, что он глуп, а потому, что никто не требует от него ответственности.

Я использовал много "AI инструментов", которые пишут быстро и рисуют неплохо, но каждый раз, когда я вижу, как он серьезно генерирует данные и запутывает логику, я понимаю одну вещь: генерация никогда не была проблемой; проверка — вот что является барьером.

Вот почему я заинтересован в @Mira_Network.

Он не пытается стать следующим ChatGPT и не собирается собирать кучу GPU для соревнований по выводу. Он просто задал вопрос с другой стороны — как мы можем доверять выводам AI?

Ответ Mira не в том, что "у нас есть более мощная модель", а в том, что: "если вы хотите, чтобы AI говорил, то нужно, чтобы его можно было проверять, привлекать к ответственности и доказывать."

Когда вы используете AI в экосистеме Mira для генерации контента, он разбивает это на ряд небольших суждений, отправляет их на проверку нескольким узлам, процесс записывается в блокчейне, результаты согласовываются, а за ошибки нужно платить.

Когда вы используете его для написания текста, поиска определения или генерации изображения, рядом будет указано: на чьем основании сделан этот вывод, есть ли согласие и является ли это надежным.

Раньше, используя AI, вы слушали, как он рассказывает истории. Теперь, используя Mira, вы смотрите, как он выполняет задания.

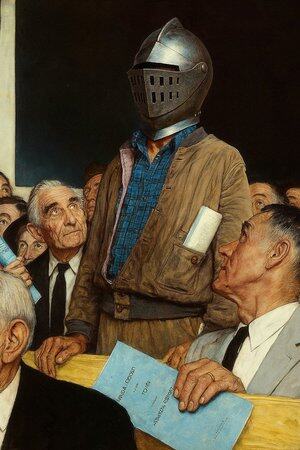

Поэтому я говорю, что это не просто приложение AI, это скорее "суд для AI".

Вы, конечно, можете продолжать использовать AI для написания статей, рисования и поиска материалов, но когда это начинает определять медицинские рекомендации, условия контрактов и доказательства в судебных разбирательствах, вам лучше иметь место, где каждое его слово будет подтверждено.

Mira — это такое место. Он не принимает решения за вас, а гарантирует, что вы видите, что не является выдумкой AI.

13,08K

Топ

Рейтинг

Избранное