Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Às vezes, a IA diz coisas erradas, não porque é estúpida, mas porque ninguém a responsabiliza.

Usei muitas "ferramentas de IA", que escrevem rapidamente e desenham decentemente, mas sempre que vejo a IA a inventar dados e a falar lógica de forma séria, percebo uma coisa: gerar nunca foi o problema; validar é que é o verdadeiro desafio.

É por isso que estou interessado na @Mira_Network.

Não está tentando ser o próximo ChatGPT, nem quer reunir um monte de GPUs para competições de inferência. Ela simplesmente fez uma pergunta sob uma nova perspectiva — como podemos confiar na saída da IA?

A resposta da Mira não é "temos um modelo mais forte", mas sim: "se você quer que a IA fale, então precisa garantir que ela possa ser verificada, responsabilizada e provada."

Quando você usa a IA na ecologia da Mira para gerar um conteúdo, ela o divide em uma série de pequenos julgamentos, enviando para vários nós para validação, o processo é escrito em blockchain, o resultado é consenso, e erros têm que ser compensados.

Se você a usa para escrever um texto, buscar uma definição ou gerar uma imagem, ao lado, ela lhe dirá: de quem é a conclusão, se há consenso e se é confiável.

Antes, ao usar a IA, você ouvia-a contar histórias. Agora, ao usar a Mira, você vê-a entregar trabalhos.

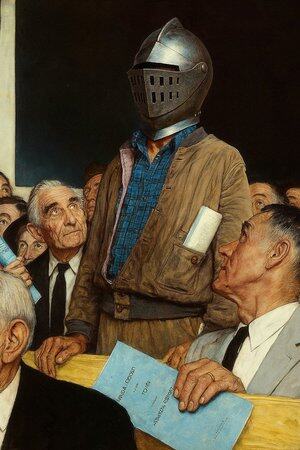

Por isso digo que não é uma aplicação de IA, é mais como um "tribunal onde a IA fala".

Você pode continuar a usar a IA para escrever, desenhar ou buscar materiais, mas quando essa coisa começa a decidir recomendações médicas, cláusulas contratuais ou evidências de litígios, é melhor ter um lugar onde cada palavra dela tenha alguém que a endosse.

A Mira é esse lugar. Não substitui seu julgamento, mas garante que o que você vê não é algo inventado pela IA.

@KaitoAI

13,06K

Top

Classificação

Favoritos