Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Noen ganger sier AI feil ting, ikke fordi det er dumt, men fordi ingen holder det ansvarlig.

Jeg har brukt mange "AI-verktøy", skrevet raskt og tegnet anstendig, men hver gang jeg ser det seriøst samle data og snakke om logikk, forstår jeg én ting: generering er aldri et problem; Verifisering er terskelen.

Det er derfor jeg bryr meg om @Mira_Network.

Den ønsker ikke å bli den neste ChatGPT, og den ønsker heller ikke å trekke en haug med GPUer for å delta i resonneringskonkurranser. Den stiller direkte spørsmålet fra et annet perspektiv - hvordan kan vi stole på resultatet av AI?

Miras svar er ikke «vi har en sterkere modell», men: «Hvis du vil at AI skal snakke, må du få det til å sjekke, bli holdt ansvarlig og bli bevist.» ”

Du bruker AI til å generere et stykke innhold i Mira-økosystemet, som vil bli delt opp i en rekke små dommer og kastet til flere noder for verifisering.

Du bruker den til å skrive et avsnitt, søke etter en definisjon, generere et diagram, og den vil fortelle deg: hvem som ga denne konklusjonen, om det er konsensus, og om den er troverdig.

Tidligere, når du brukte AI, lyttet du til den fortelle historier. Nå med Mira ser du det snu i leksene.

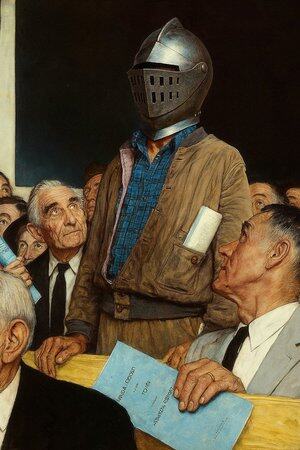

Så jeg sier at det ikke er en AI-applikasjon, det er mer som en "AI-snakkende domstol".

Selvfølgelig kan du fortsette å bruke AI til å skrive, tegne og finne materiale, men når denne tingen begynner å diktere medisinske råd, kontraktsvilkår, rettsbevis, bør du ha et sted hvor det kan godkjennes av noen for hvert ord.

Mira er et slikt sted. Det handler ikke om å dømme for deg, men om å sørge for at det du ser ikke er laget av AI.

@KaitoAI

13,07K

Topp

Rangering

Favoritter