Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Terkadang AI mengatakan hal yang salah, bukan karena bodoh, tetapi karena tidak ada yang meminta pertanggungjawabannya.

Saya telah menggunakan banyak "alat AI", menulis dengan cepat dan menggambar dengan sopan, tetapi setiap kali saya melihatnya dengan serius mengumpulkan data dan berbicara tentang logika, saya mengerti satu hal: generasi tidak pernah menjadi masalah; Verifikasi adalah ambang batas.

Itu sebabnya saya peduli dengan @Mira_Network.

Itu tidak ingin menjadi ChatGPT berikutnya, juga tidak ingin menarik banyak GPU untuk terlibat dalam kompetisi penalaran. Ini secara langsung mengajukan pertanyaan dari perspektif yang berbeda - bagaimana kita bisa mempercayai output AI?

Jawaban Mira bukanlah "kami memiliki model yang lebih kuat", tetapi: "Jika Anda ingin AI berbicara, Anda harus memeriksanya, dimintai pertanggungjawaban, dan terbukti." ”

Anda menggunakan AI untuk menghasilkan konten di ekosistem Mira, yang akan dipecah menjadi serangkaian penilaian kecil dan dilemparkan ke beberapa node untuk verifikasi.

Anda menggunakannya untuk menulis paragraf, mencari definisi, membuat diagram, dan itu akan memberi tahu Anda: siapa yang memberikan kesimpulan ini, apakah ada konsensus, dan apakah itu kredibel.

Di masa lalu, ketika Anda menggunakan AI, Anda mendengarkannya bercerita. Sekarang dengan Mira, Anda melihatnya berubah menjadi pekerjaan rumah.

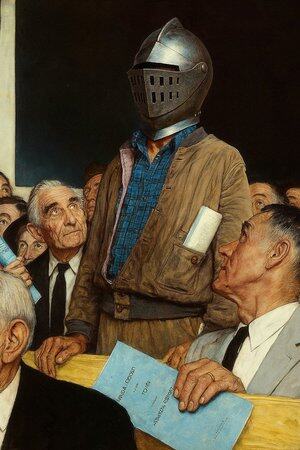

Jadi saya katakan ini bukan aplikasi AI, ini lebih seperti "pengadilan berbicara AI".

Tentu saja, Anda dapat terus menggunakan AI untuk menulis, menggambar, dan menemukan materi, tetapi ketika hal ini mulai mendikte saran medis, persyaratan kontrak, bukti litigasi, Anda sebaiknya memiliki tempat di mana AI dapat didukung oleh seseorang untuk setiap kata.

Mira adalah salah satu tempat tersebut. Ini bukan tentang menilai untuk Anda, tetapi tentang memastikan bahwa apa yang Anda lihat tidak dibuat oleh AI.

@KaitoAI

13,08K

Teratas

Peringkat

Favorit