Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Іноді штучний інтелект говорить неправильні речі не тому, що це безглуздо, а тому, що ніхто не притягує його до відповідальності.

Я користувався багатьма «інструментами штучного інтелекту», писав швидко і пристойно малював, але щоразу, коли бачу, що це серйозно збирає дані та говорить про логіку, я розумію одне: генерація ніколи не буває проблемою; Верифікація – це поріг.

Тому я дбаю про @Mira_Network.

Він не хоче бути наступним ChatGPT, а також не хоче тягнути купу графічних процесорів, щоб брати участь у змаганнях з міркувань. Це прямо ставить питання з іншої точки зору - як ми можемо довіряти результатам штучного інтелекту?

Відповідь Міри не «у нас сильніша модель», а «якщо ви хочете, щоб штучний інтелект говорив, ви повинні зробити так, щоб це перевірили, притягнули до відповідальності та довели». ”

Ви використовуєте штучний інтелект для створення шматка контенту в екосистемі Mira, який буде розбитий на серію невеликих суджень і перекинутий на кілька вузлів для перевірки.

З його допомогою ви пишете абзац, шукаєте визначення, генеруєте діаграму, і він розповість вам: хто дав цей висновок, чи є консенсус і чи заслуговує він на довіру.

Раніше, коли ви використовували штучний інтелект, ви слухали, як він розповідає історії. Тепер з Мірою ви бачите, як вона повертається до домашнього завдання.

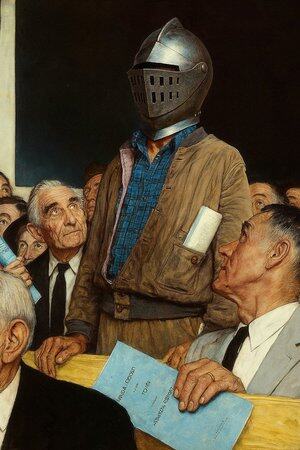

Тому я кажу, що це не додаток для штучного інтелекту, це більше схоже на «суд для розмов зі штучним інтелектом».

Звичайно, ви можете продовжувати використовувати штучний інтелект для написання, малювання та пошуку матеріалів, але коли ця річ починає диктувати медичні поради, умови контракту, судові докази, вам краще мати місце, де це може бути схвалено кимось за кожне слово.

Міра – одне з таких місць. Йдеться не про те, щоб засуджувати за вас, а про те, щоб переконатися, що те, що ви бачите, не вигадано штучним інтелектом.

@KaitoAI

13,07K

Найкращі

Рейтинг

Вибране