Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Đôi khi AI nói sai không phải vì nó ngu ngốc, mà vì không ai yêu cầu nó phải chịu trách nhiệm.

Tôi đã sử dụng nhiều "công cụ AI", viết rất nhanh, vẽ cũng khá ổn, nhưng mỗi khi thấy nó nghiêm túc biên soạn dữ liệu, nói lung tung về logic, tôi hiểu một điều: việc tạo ra không bao giờ là vấn đề; việc xác minh mới là rào cản.

Đó là lý do tại sao tôi quan tâm đến @Mira_Network.

Nó không muốn trở thành ChatGPT tiếp theo, cũng không muốn kéo một đống GPU để tổ chức cuộc thi suy luận. Nó đã đặt ra một câu hỏi từ một góc độ khác - làm thế nào chúng ta có thể tin tưởng vào đầu ra của AI?

Câu trả lời mà Mira đưa ra không phải là "chúng tôi có một mô hình mạnh hơn", mà là: "Nếu bạn muốn AI nói chuyện, thì bạn phải để nó có thể được kiểm tra, có thể bị truy cứu trách nhiệm, có thể được chứng minh."

Khi bạn sử dụng AI trong hệ sinh thái Mira để tạo ra một nội dung, nó sẽ phân tách thành một chuỗi các phán đoán nhỏ, gửi đến nhiều nút để xác minh, quá trình viết chuỗi, kết quả đồng thuận, sai sót phải bồi thường.

Khi bạn sử dụng nó để viết một đoạn văn, tìm một định nghĩa, tạo ra một bức tranh, bên cạnh sẽ cho bạn biết: kết luận này dựa vào ai, có đồng thuận không, có đáng tin cậy không.

Trước đây, khi sử dụng AI, bạn chỉ nghe nó kể chuyện. Bây giờ khi sử dụng Mira, bạn thấy nó làm bài tập.

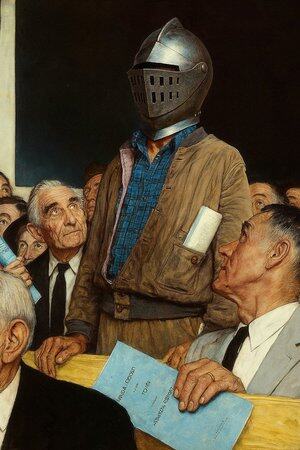

Vì vậy, tôi nói nó không phải là một ứng dụng AI, mà giống như một "tòa án để AI nói chuyện".

Bạn chắc chắn có thể tiếp tục sử dụng AI để viết bài, vẽ tranh, tìm tài liệu, nhưng khi thứ này bắt đầu quyết định các khuyến nghị y tế, điều khoản hợp đồng, bằng chứng tố tụng, bạn tốt nhất nên có một nơi mà mọi câu nói của nó đều có người đứng ra bảo đảm.

Mira chính là một nơi như vậy. Nó không thay bạn phán đoán, mà đảm bảo rằng những gì bạn thấy không phải là do AI bịa ra.

13,08K

Hàng đầu

Thứ hạng

Yêu thích