المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

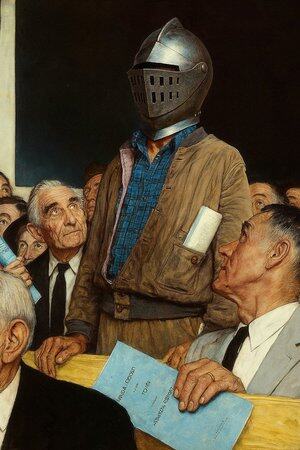

في بعض الأحيان يقول الذكاء الاصطناعي الشيء الخطأ ، ليس لأنه غبي ، ولكن لأنه لا أحد يحاسبه.

لقد استخدمت العديد من "أدوات الذكاء الاصطناعي" ، والكتابة بسرعة والرسم بشكل لائق ، ولكن في كل مرة أراها تجمع البيانات بجدية وتتحدث عن المنطق ، أفهم شيئا واحدا: التوليد ليس مشكلة أبدا. التحقق هو العتبة.

لهذا السبب أهتم @Mira_Network.

لا تريد أن تكون ChatGPT التالية ، ولا تريد سحب مجموعة من وحدات معالجة الرسومات للمشاركة في مسابقات التفكير. إنه يطرح السؤال مباشرة من منظور مختلف - كيف يمكننا الوثوق بمخرجات الذكاء الاصطناعي؟

إجابة ميرا ليست "لدينا نموذج أقوى" ، ولكن: "إذا كنت تريد أن يتحدث الذكاء الاصطناعي ، فعليك أن تجعله يتحقق ، ويخضع للمساءلة ، وأن يتم إثباته". ”

يمكنك استخدام الذكاء الاصطناعي لإنشاء جزء من المحتوى في نظام Mira البيئي ، والذي سيتم تقسيمه إلى سلسلة من الأحكام الصغيرة وإلقاؤه على عقد متعددة للتحقق.

يمكنك استخدامه لكتابة فقرة ، والبحث عن تعريف ، وإنشاء رسم تخطيطي ، وسيخبرك: من الذي قدم هذا الاستنتاج ، وما إذا كان هناك إجماع ، وما إذا كان ذا مصداقية.

في الماضي ، عندما كنت تستخدم الذكاء الاصطناعي ، كنت تستمع إليه وهو يروي القصص. الآن مع ميرا ، ترى أنها تتحول في الواجب المنزلي.

لذلك أقول إنه ليس تطبيقا الذكاء الاصطناعي ، إنه أشبه ب "محكمة الذكاء الاصطناعي تتحدث".

بالطبع ، يمكنك الاستمرار في استخدام الذكاء الاصطناعي لكتابة المواد ورسمها والعثور عليها ، ولكن عندما يبدأ هذا الشيء في إملاء المشورة الطبية وشروط العقد وأدلة التقاضي ، فمن الأفضل أن يكون لديك مكان يمكن أن يصادق عليه شخص ما لكل كلمة.

ميرا هي واحدة من هذه الأماكن. لا يتعلق الأمر بالحكم نيابة عنك ، ولكن بالتأكد من أن ما تراه لا يتكون من الذكاء الاصطناعي.

@KaitoAI

13.07K

الأفضل

المُتصدِّرة

التطبيقات المفضلة