Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Bạn đang trong một cuộc phỏng vấn Nhà khoa học nghiên cứu tại Google.

Người phỏng vấn: Chúng tôi có một LLM cơ bản mà rất tệ trong toán học. Bạn sẽ biến nó thành một cỗ máy mạnh mẽ về toán học và lý luận như thế nào?

Bạn: Tôi sẽ lấy một số bài toán được gán nhãn và tinh chỉnh mô hình.

Cuộc phỏng vấn kết thúc.

Đây là những gì bạn đã bỏ lỡ:

Khi các đầu ra có thể xác minh, nhãn trở nên tùy chọn.

Toán học, mã và logic có thể được kiểm tra và xác thực tự động.

Hãy sử dụng thực tế này để xây dựng một mô hình lý luận mà không cần gán nhãn thủ công.

Chúng ta sẽ sử dụng:

- @UnslothAI để tinh chỉnh hiệu quả tham số.

- @HuggingFace TRL để áp dụng GRPO.

Đi nào! 🚀

GRPO là gì?

Tối ưu hóa chính sách tương đối nhóm (Group Relative Policy Optimization) là một phương pháp học tăng cường điều chỉnh các mô hình ngôn ngữ lớn (LLMs) cho các nhiệm vụ toán học và lý luận bằng cách sử dụng các hàm thưởng xác định, loại bỏ nhu cầu về dữ liệu được gán nhãn.

Dưới đây là một cái nhìn tổng quan ngắn gọn về GRPO trước khi chúng ta đi vào mã:

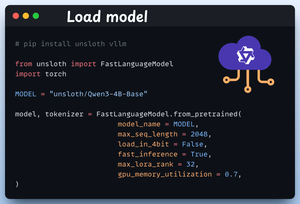

1️⃣ Tải mô hình

Chúng ta bắt đầu bằng cách tải Qwen3-4B-Base và bộ mã hóa của nó bằng cách sử dụng Unsloth.

Bạn có thể sử dụng bất kỳ LLM có trọng số mở nào khác ở đây.

Kiểm tra cái này 👇

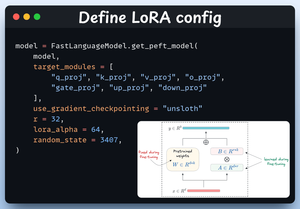

2️⃣ Định nghĩa cấu hình LoRA

Chúng ta sẽ sử dụng LoRA để tránh việc tinh chỉnh toàn bộ trọng số của mô hình. Trong đoạn mã này, chúng ta sử dụng PEFT của Unsloth bằng cách chỉ định:

- Mô hình

- LoRA hạng thấp (r)

- Các mô-đun để tinh chỉnh, v.v.

Kiểm tra cái này 👇

3️⃣ Tạo tập dữ liệu

Chúng tôi tải tập dữ liệu Open R1 Math (một tập dữ liệu bài toán toán học) và định dạng nó cho việc suy luận.

Mỗi mẫu bao gồm:

- Một lời nhắc hệ thống yêu cầu suy luận có cấu trúc

- Một câu hỏi từ tập dữ liệu

- Câu trả lời theo định dạng yêu cầu

Kiểm tra mã này 👇

4️⃣ Định nghĩa các hàm thưởng

Trong GRPO, chúng tôi sử dụng các hàm xác định để xác thực phản hồi và gán thưởng.

Không cần gán nhãn thủ công!

Các hàm thưởng:

- Khớp định dạng chính xác

- Khớp định dạng gần đúng

- Kiểm tra câu trả lời

- Kiểm tra số

Xem cái này 👇

5️⃣ Sử dụng GRPO và bắt đầu đào tạo

Bây giờ chúng ta đã có tập dữ liệu và các hàm thưởng sẵn sàng, đã đến lúc áp dụng GRPO.

HuggingFace TRL cung cấp mọi thứ mà chúng ta đã mô tả trong sơ đồ GRPO, ngay lập tức, dưới dạng GRPOConfig và GRPOTrainer.

Xem cái này👇

6️⃣ So sánh

Một lần nữa, chúng ta có thể thấy cách mà GRPO đã biến một mô hình cơ bản thành một cỗ máy lý luận.

Xem cái này👇

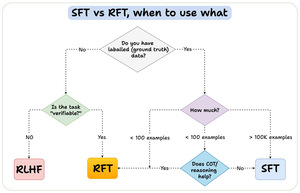

Trước khi chúng ta kết thúc, hãy để tôi giải quyết một câu hỏi quan trọng:

Khi nào bạn nên sử dụng tinh chỉnh tăng cường (RFT) so với tinh chỉnh có giám sát (SFT)?

Tôi đã tạo ra sơ đồ này để cung cấp câu trả lời:

157,42K

Hàng đầu

Thứ hạng

Yêu thích