Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Вы на интервью на должность научного сотрудника в Google.

Интервьюер: У нас есть базовая LLM, которая ужасно справляется с математикой. Как бы вы превратили её в мощный инструмент для математики и логического мышления?

Вы: Я помечу несколько задач и дообучу модель.

Интервью завершено.

Вот что вы пропустили:

Когда выходы можно проверить, метки становятся необязательными.

Математика, код и логика могут быть автоматически проверены и валидированы.

Давайте используем этот факт, чтобы построить модель рассуждений без ручной маркировки.

Мы будем использовать:

- @UnslothAI для эффективной настройки параметров.

- @HuggingFace TRL для применения GRPO.

Вперед! 🚀

Что такое GRPO?

Group Relative Policy Optimization — это метод обучения с подкреплением, который настраивает LLM для задач математики и логического мышления, используя детерминированные функции вознаграждения, что устраняет необходимость в размеченных данных.

Вот краткий обзор GRPO, прежде чем мы перейдем к коду:

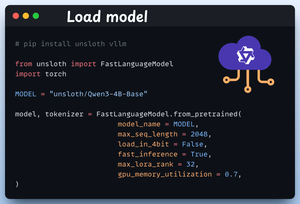

1️⃣ Загрузите модель

Мы начинаем с загрузки Qwen3-4B-Base и его токенизатора с помощью Unsloth.

Вы можете использовать любую другую LLM с открытыми весами.

Проверьте это 👇

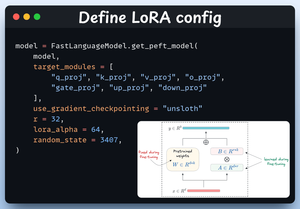

2️⃣ Определите конфигурацию LoRA

Мы будем использовать LoRA, чтобы избежать дообучения всех весов модели. В этом коде мы используем PEFT от Unsloth, указывая:

- Модель

- Низкий ранг LoRA (r)

- Модули для дообучения и т.д.

Проверьте это 👇

3️⃣ Создайте набор данных

Мы загружаем набор данных Open R1 Math (набор данных с математическими задачами) и форматируем его для рассуждений.

Каждый образец включает:

- Системный запрос, обеспечивающий структурированное рассуждение

- Вопрос из набора данных

- Ответ в требуемом формате

Проверьте этот код 👇

4️⃣ Определите функции вознаграждения

В GRPO мы используем детерминированные функции для проверки ответа и назначения вознаграждения.

Без необходимости в ручной разметке!

Функции вознаграждения:

- Точно совпадать с форматом

- Приблизительно совпадать с форматом

- Проверить ответ

- Проверить числа

Посмотрите это 👇

5️⃣ Используйте GRPO и начните обучение

Теперь, когда у нас есть набор данных и функции вознаграждения, пришло время применить GRPO.

HuggingFace TRL предоставляет все, что мы описали в диаграмме GRPO, из коробки, в виде GRPOConfig и GRPOTrainer.

Посмотрите на это👇

6️⃣ Сравнение

Снова мы можем увидеть, как GRPO превратил базовую модель в мощный инструмент для рассуждений.

Посмотрите на это👇

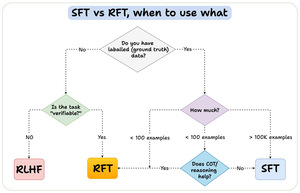

Прежде чем мы завершим, позвольте мне ответить на важный вопрос:

Когда следует использовать обучение с подкреплением (RFT) по сравнению с контролируемым обучением (SFT)?

Я создал эту диаграмму, чтобы дать ответ:

157,41K

Топ

Рейтинг

Избранное