Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Estás en una entrevista para Científico de Investigación en Google.

Entrevistador: Tenemos un LLM base que es terrible en matemáticas. ¿Cómo lo convertirías en una potencia de matemáticas y razonamiento?

Tú: Etiquetaré algunos problemas y ajustaré el modelo.

Entrevista terminada.

Esto es lo que te perdiste:

Cuando las salidas son verificables, las etiquetas se vuelven opcionales.

Las matemáticas, el código y la lógica pueden ser comprobados y validados automáticamente.

Utilicemos este hecho para construir un modelo de razonamiento sin etiquetado manual.

Usaremos:

- @UnslothAI para un ajuste fino eficiente en parámetros.

- @HuggingFace TRL para aplicar GRPO.

¡Vamos! 🚀

¿Qué es GRPO?

La Optimización de Políticas Relativas de Grupo es un método de aprendizaje por refuerzo que ajusta los LLM para tareas de matemáticas y razonamiento utilizando funciones de recompensa deterministas, eliminando la necesidad de datos etiquetados.

Aquí hay un breve resumen de GRPO antes de que pasemos al código:

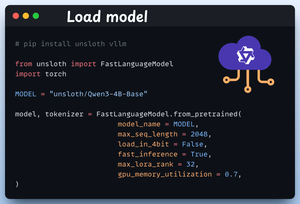

1️⃣ Carga el modelo

Comenzamos cargando Qwen3-4B-Base y su tokenizador usando Unsloth.

Puedes usar cualquier otro LLM de peso abierto aquí.

Mira esto 👇

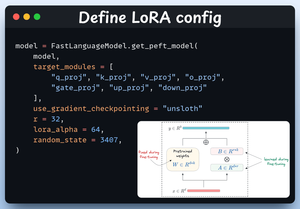

2️⃣ Definir la configuración de LoRA

Usaremos LoRA para evitar ajustar los pesos de todo el modelo. En este código, utilizamos PEFT de Unsloth especificando:

- El modelo

- LoRA de rango bajo (r)

- Módulos para el ajuste fino, etc.

Consulta esto 👇

3️⃣ Crea el conjunto de datos

Cargamos el conjunto de datos Open R1 Math (un conjunto de datos de problemas matemáticos) y lo formateamos para el razonamiento.

Cada muestra incluye:

- Un aviso del sistema que impone un razonamiento estructurado

- Una pregunta del conjunto de datos

- La respuesta en el formato requerido

Revisa este código 👇

4️⃣ Definir funciones de recompensa

En GRPO utilizamos funciones deterministas para validar la respuesta y asignar una recompensa.

¡No se requiere etiquetado manual!

Las funciones de recompensa:

- Coincidir exactamente con el formato

- Coincidir aproximadamente con el formato

- Verificar la respuesta

- Verificar números

Mira esto 👇

5️⃣ Usa GRPO y comienza a entrenar

Ahora que tenemos el conjunto de datos y las funciones de recompensa listas, es hora de aplicar GRPO.

HuggingFace TRL proporciona todo lo que describimos en el diagrama de GRPO, listo para usar, en forma de GRPOConfig y GRPOTrainer.

Mira esto👇

6️⃣ Comparación

Una vez más, podemos ver cómo GRPO convirtió un modelo base en una potencia de razonamiento.

Mira esto👇

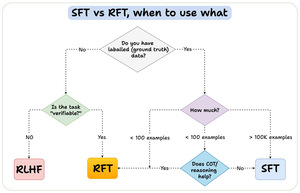

Antes de concluir, permíteme abordar una pregunta importante:

¿Cuándo deberías usar el ajuste fino por refuerzo (RFT) en lugar del ajuste fino supervisado (SFT)?

Creé este diagrama para proporcionar una respuesta:

157,42K

Parte superior

Clasificación

Favoritos