Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Du er i et intervju som forsker hos Google.

Intervjuer: Vi har en grunnleggende LLM som er elendig i matte. Hvordan ville du gjort det til et kraftsenter innen matematikk og resonnement?

Du: Jeg skal få noen problemer merket og finjustere modellen.

Intervjuet er over.

Her er det du gikk glipp av:

Når utdata kan verifiseres, blir etiketter valgfrie.

Matematikk, kode og logikk kan automatisk sjekkes og valideres.

La oss bruke dette faktum til å bygge en resonnementsmodell uten manuell merking.

Vi vil bruke:

- @UnslothAI for parameter-effektiv finjustering.

- @HuggingFace TRL for å påføre GRPO.

La oss gå! 🚀

Hva er GRPO?

Group Relative Policy Optimization er en forsterkende læringsmetode som finjusterer LLM-er for matematikk- og resonneringsoppgaver ved hjelp av deterministiske belønningsfunksjoner, noe som eliminerer behovet for merkede data.

Her er en kort oversikt over GRPO før vi hopper inn i koden:

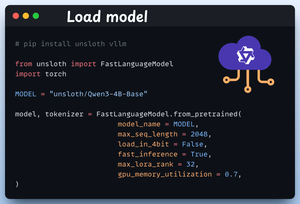

1️⃣ Last inn modellen

Vi starter med å laste Qwen3-4B-Base og dens tokenizer ved hjelp av Unsloth.

Du kan bruke hvilken som helst annen LLM med åpen vekt her.

Sjekk dette 👇

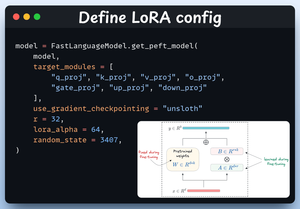

2️⃣ Definer LoRA-konfigurasjon

Vi bruker LoRA for å unngå å finjustere hele modellvektene. I denne koden bruker vi Unsloths PEFT ved å spesifisere:

- Modellen

- LoRA lav rang (r)

- Moduler for finjustering osv.

Sjekk dette 👇

3️⃣ Opprett datasettet

Vi laster inn Open R1 Math-datasett (et matematisk problemdatasett) og formaterer det for resonnement.

Hver prøve inkluderer:

- En systemmelding som håndhever strukturert resonnement

- Et spørsmål fra datasettet

- Svaret i ønsket format

Sjekk denne koden 👇

4️⃣ Definer belønningsfunksjoner

I GRPO bruker vi deterministiske funksjoner for å validere svaret og tildele en belønning.

Ingen manuell merking kreves!

Belønningen fungerer:

- Match format nøyaktig

- Matchformat omtrent

- Sjekk svaret

- Sjekk tall

Sjekk dette ut 👇

5️⃣ Bruk GRPO og begynn å trene

Nå som vi har datasettet og belønningsfunksjonene klare, er det på tide å bruke GRPO.

HuggingFace TRL gir alt vi beskrev i GRPO-diagrammet, ut av esken, i form av GRPOConfig og GRPOTrainer.

Sjekk dette ut👇

6️⃣ Sammenligning

Igjen kan vi se hvordan GRPO gjorde en basismodell til et resonnerende kraftsenter.

Sjekk dette ut👇

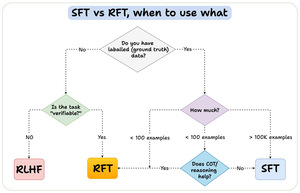

Før vi avslutter, la meg ta opp et viktig spørsmål:

Når bør du bruke forsterkningsfinjustering (RFT) kontra overvåket finjustering (SFT)?

Jeg laget dette diagrammet for å gi et svar:

157,42K

Topp

Rangering

Favoritter