Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Du är på en intervju för forskare på Google.

Intervjuare: Vi har en grundläggande LLM som är usel på matte. Hur skulle du göra det till en matematik- och resonemangskraft?

Du: Jag ska få några problem märkta och finjustera modellen.

Intervjun är över.

Här är vad du missade:

När utdata är verifierbara blir etiketter valfria.

Matematik, kod och logik kan automatiskt kontrolleras och valideras.

Låt oss använda detta faktum för att bygga en resonemangsmodell utan manuell märkning.

Vi kommer att använda:

- @UnslothAI för parameter-effektiv finjustering.

- @HuggingFace TRL för att tillämpa GRPO.

Kom så går vi! 🚀

Vad är GRPO?

Group Relative Policy Optimization är en metod för förstärkningsinlärning som finjusterar LLM:er för matematiska och resonerande uppgifter med hjälp av deterministiska belöningsfunktioner, vilket eliminerar behovet av märkta data.

Här är en kort översikt över GRPO innan vi går in på kod:

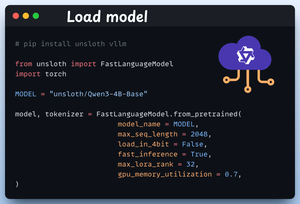

1️⃣ Ladda modellen

Vi börjar med att ladda Qwen3-4B-Base och dess tokenizer med Unsloth.

Du kan använda vilken annan LLM med öppen vikt som helst här.

Kolla in det här 👇

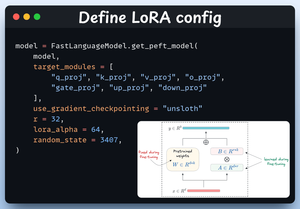

2️⃣ Definiera LoRA-konfiguration

Vi kommer att använda LoRA för att undvika att finjustera hela modellens vikter. I den här koden använder vi Unsloths PEFT genom att ange:

- Modellen

- LoRA låg rang (r)

- Moduler för finjustering m.m.

Kolla in det här 👇

3️⃣ Skapa datauppsättningen

Vi laddar Open R1 Math dataset (en matematisk problemdatauppsättning) och formaterar den för resonemang.

Varje prov innehåller:

- En systemprompt som tvingar fram strukturerat resonemang

- En fråga från datasetet

- Svaret i det format som krävs

Kontrollera den här koden 👇

4️⃣ Definiera belöningsfunktioner

I GRPO använder vi deterministiska funktioner för att validera svaret och tilldela en belöning.

Ingen manuell märkning krävs!

Belöningsfunktionerna:

- Matcha formatet exakt

- Matcha formatet ungefär

- Kontrollera svaret

- Kontrollera nummer

Kolla in det här 👇

5️⃣ Använd GRPO och börja träna

Nu när vi har datauppsättnings- och belöningsfunktionerna klara är det dags att tillämpa GRPO.

HuggingFace TRL tillhandahåller allt vi beskrev i GRPO-diagrammet, direkt ur lådan, i form av GRPOConfig och GRPOTrainer.

Kolla in det här👇

6️⃣ Jämförelse

Återigen kan vi se hur GRPO förvandlade en basmodell till ett kraftpaket för resonemang.

Kolla in det här👇

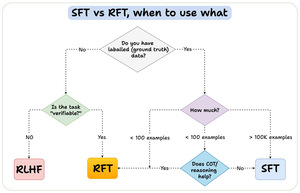

Innan vi avslutar vill jag ta upp en viktig fråga:

När ska du använda förstärkningsfinjustering (RFT) kontra övervakad finjustering (SFT)?

Jag skapade det här diagrammet för att ge ett svar:

157,4K

Topp

Rankning

Favoriter