Trend Olan Konular

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Google'da bir Araştırma Bilimcisi mülakatındasın.

Röportajcı: Matematikte çok kötü olan bir temel LLM'imiz var. Bunu matematik ve akıl yürütme alanında bir güç merkezine nasıl dönüştürürdün?

Sen: Bazı sorunları etiketleyip modeli ince ayarlarım.

Mülakat bitti.

İşte kaçırdığınız şeyler:

Çıkışlar doğrulanabilir olduğunda, etiketler isteğe bağlı hale gelir.

Matematik, kod ve mantık otomatik olarak kontrol edilip doğrulanabilir.

Bu gerçeği manuel etiketleme olmadan bir akıl yürütme modeli oluşturmak için kullanalım.

Şunları kullanacağız:

- @UnslothAI parametre verimli ince ayar için.

- GRPO uygulamak için TRL @HuggingFace.

Gidelim! 🚀

GRPO nedir?

Grup Bağıl Politika Optimizasyonu, deterministik ödül fonksiyonlarını kullanarak matematik ve muhakeme görevleri için LLM'lere ince ayar yapan ve etiketli verilere olan ihtiyacı ortadan kaldıran bir takviyeli öğrenme yöntemidir.

Koda geçmeden önce GRPO'ya kısa bir genel bakış:

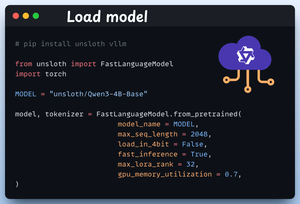

1️⃣ Modeli yükleyin

Unsloth kullanarak Qwen3-4B-Base'i ve tokenizer'ını yükleyerek başlıyoruz.

Burada başka herhangi bir açık ağırlıklı LLM'yi kullanabilirsiniz.

Bunu 👇 kontrol et

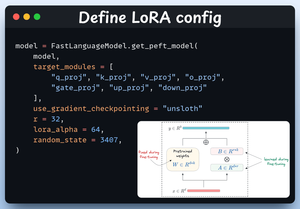

2️⃣ LoRA yapılandırmasını tanımlayın

Tüm model ağırlıklarında ince ayar yapmaktan kaçınmak için LoRA kullanacağız. Bu kodda, Unsloth'un PEFT'sini aşağıdakileri belirterek kullanıyoruz:

- Model

- LoRA düşük dereceli (r)

- İnce ayar vb. için modüller.

Bunu 👇 kontrol et

3️⃣ Veri kümesini oluşturun

Open R1 Math veri setini (bir matematik problemi veri seti) yüklüyoruz ve akıl yürütme için biçimlendiriyoruz.

Her örnek şunları içerir:

- Yapılandırılmış akıl yürütmeyi zorlayan bir sistem istemi

- Veri kümesinden bir soru

- Gerekli formatta cevap

Bu kodu 👇 kontrol et

4️⃣ Ödül işlevlerini tanımlayın

GRPO'da yanıtı doğrulamak ve bir ödül atamak için deterministik işlevler kullanırız.

Manuel etiketlemeye gerek yok!

Ödül fonksiyonları:

- Formatı tam olarak eşleştir

- Maç formatı yaklaşık olarak

- Cevabı kontrol et

- Numaraları kontrol edin

Şuna bir bak 👇

5️⃣ GRPO'yu kullanın ve eğitime başlayın

Artık veri kümesi ve ödül fonksiyonları hazır olduğuna göre, GRPO'yu uygulama zamanı.

HuggingFace TRL, GRPO diyagramında tanımladığımız her şeyi kutudan çıkar çıkmaz GRPOConfig ve GRPOTrainer biçiminde sağlar.

Şuna bir bak👇

6️⃣ Karşılaştırma

Yine, GRPO'nun bir temel modeli nasıl bir akıl yürütme gücüne dönüştürdüğünü görebiliriz.

Şuna bir bak👇

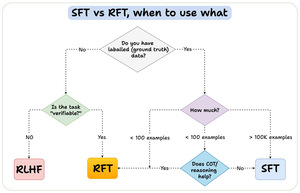

Bitirmeden önce önemli bir soruya değineyim:

Denetimli ince ayar (SFT) yerine takviye ince ayarını (RFT) ne zaman kullanmalısınız?

Bir cevap sağlamak için bu diyagramı oluşturdum:

157,35K

En İyiler

Sıralama

Takip Listesi