Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ești într-un interviu pentru cercetători la Google.

Intervievator: Avem un LLM de bază care este groaznic la matematică. Cum ai transforma-o într-o forță în matematică și raționament?

Tu: O să etichetez niște probleme și o să ajustez modelul.

Interviul s-a încheiat.

Iată ce ai ratat:

Când ieșirile sunt verificabile, etichetele devin opționale.

Matematica, codul și logica pot fi verificate și validate automat.

Să folosim acest fapt pentru a construi un model de raționament fără etichetare manuală.

Vom folosi:

- @UnslothAI pentru reglare fină eficientă din punct de vedere al parametrilor.

- @HuggingFace TRL pentru a aplica GRPO.

Să mergem! 🚀

Ce este GRPO?

Group Relative Policy Optimization este o metodă de învățare prin întărire care reglează LLM-urile pentru sarcini de matematică și raționament folosind funcții de recompensă deterministe, eliminând nevoia de date etichetate.

Iată o scurtă prezentare generală a GRPO înainte de a trece la cod:

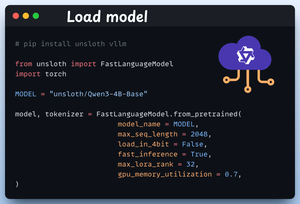

1️⃣ Încărcați modelul

Începem prin a încărca Qwen3-4B-Base și tokenizatorul său folosind Unsloth.

Puteți utiliza orice alt LLM cu greutate deschisă aici.

Verificați acest lucru 👇

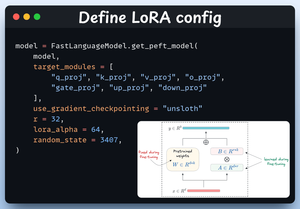

2️⃣ Definiți configurația LoRA

Vom folosi LoRA pentru a evita reglarea fină a întregii greutăți ale modelului. În acest cod, folosim PEFT al lui Unsloth specificând:

- Modelul

- LoRA de rang scăzut (r)

- Module pentru reglare fină etc.

Verificați acest lucru 👇

3️⃣ Creați setul de date

Încărcăm setul de date Open R1 Math (un set de date cu probleme matematice) și îl formatăm pentru raționament.

Fiecare eșantion include:

- Un prompt de sistem care impune raționamentul structurat

- O întrebare din setul de date

- Răspunsul în formatul dorit

Verificați acest cod 👇

4️⃣ Definiți funcțiile de recompensă

În GRPO folosim funcții deterministe pentru a valida răspunsul și a atribui o recompensă.

Nu este necesară etichetarea manuală!

Funcțiile de recompensă:

- Potriviți exact formatul

- Formatul meciului aproximativ

- Verificați răspunsul

- Numere de verificare

Verificați 👇 acest lucru

5️⃣ Utilizați GRPO și începeți antrenamentul

Acum că avem setul de date și funcțiile de recompensă gata, este timpul să aplicăm GRPO.

HuggingFace TRL oferă tot ceea ce am descris în diagrama GRPO, ieșit din cutie, sub forma GRPOConfig și GRPOTrainer.

Verificați👇 acest lucru

6️⃣ Comparație

Din nou, putem vedea cum GRPO a transformat un model de bază într-o putere de raționament.

Verificați👇 acest lucru

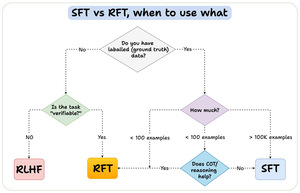

Înainte de a încheia, permiteți-mi să abordez o întrebare importantă:

Când ar trebui să utilizați reglarea fină a armăturii (RFT) versus reglarea fină supravegheată (SFT)?

Am creat această diagramă pentru a oferi un răspuns:

157,43K

Limită superioară

Clasament

Favorite