Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Você está em uma entrevista para Cientista Pesquisador no Google.

Entrevistador: Temos um LLM básico que é péssimo em matemática. Como você transformaria isso em uma potência de matemática e raciocínio?

Você: Vou marcar alguns problemas e ajustar o modelo.

Entrevista encerrada.

Aqui está o que você perdeu:

Quando as saídas são verificáveis, os rótulos tornam-se opcionais.

Matemática, código e lógica podem ser verificados e validados automaticamente.

Vamos usar esse fato para construir um modelo de raciocínio sem rotulagem manual.

Vamos usar:

- @UnslothAI para ajuste fino eficiente em parametros.

- @HuggingFace TRL para aplicar GRPO.

Vamos! 🚀

O que é GRPO?

A Otimização de Política Relativa de Grupo é um método de aprendizado por reforço que ajusta LLMs para tarefas de matemática e raciocínio usando funções de recompensa determinísticas, eliminando a necessidade de dados rotulados.

Aqui está uma breve visão geral do GRPO antes de entrarmos no código:

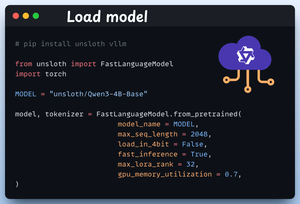

1️⃣ Carregue o modelo

Começamos carregando o Qwen3-4B-Base e seu tokenizer usando o Unsloth.

Você pode usar qualquer outro LLM de peso aberto aqui.

Verifique isso 👇

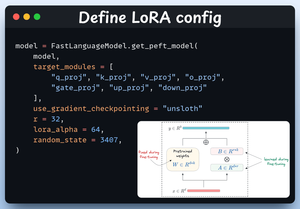

2️⃣ Definir configuração LoRA

Usaremos LoRA para evitar o ajuste fino de todos os pesos do modelo. Neste código, usamos o PEFT da Unsloth especificando:

- O modelo

- LoRA de classificação baixa (r)

- Módulos para ajuste fino, etc.

Verifique isso 👇

3️⃣ Crie o conjunto de dados

Carregamos o conjunto de dados Open R1 Math (um conjunto de dados de problemas matemáticos) e o formatamos para raciocínio.

Cada amostra inclui:

- Um prompt do sistema que impõe o raciocínio estruturado

- Uma pergunta do conjunto de dados

- A resposta no formato exigido

Verifique este código 👇

4️⃣ Defina funções de recompensa

No GRPO, usamos funções determinísticas para validar a resposta e atribuir uma recompensa.

Não é necessária rotulagem manual!

As funções de recompensa:

- Formato de correspondência exatamente

- Formato de correspondência aproximadamente

- Verifique a resposta

- Números de verificação

Confira isso 👇

5️⃣ Use o GRPO e comece a treinar

Agora que temos o conjunto de dados e as funções de recompensa prontos, é hora de aplicar o GRPO.

O HuggingFace TRL fornece tudo o que descrevemos no diagrama GRPO, pronto para uso, na forma do GRPOConfig e do GRPOTrainer.

Confira isso👇

6️⃣ Comparação

Novamente, podemos ver como o GRPO transformou um modelo básico em uma potência de raciocínio.

Confira isso👇

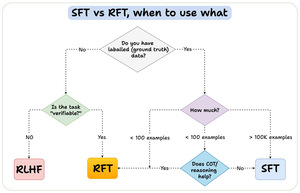

Antes de concluirmos, deixe-me abordar uma questão importante:

Quando você deve usar o ajuste fino de reforço (RFT) versus o ajuste fino supervisionado (SFT)?

Criei este diagrama para fornecer uma resposta:

157,42K

Melhores

Classificação

Favoritos